Frustratie over valse AI-detectie: Wat betekent het voor de toekomst van academisch schrijven?

Blogmaandag, 20 mei 2024 om 21:44

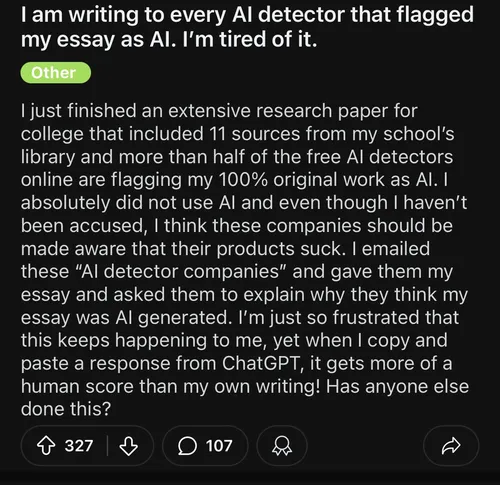

In een recent bericht op sociale media uitte een student zijn frustratie over het feit dat zijn volledig originele werk door meerdere AI-detectoren als door AI gegenereerd werd gemarkeerd. Dit roept vragen op over de betrouwbaarheid van deze detectietools en de impact die ze hebben op academisch schrijven. Laten we deze kwestie nader bekijken en de implicaties voor zowel studenten als de technologie verkennen.

De Onbetrouwbaarheid van AI-Detectietools

AI-detectoren zijn ontworpen om het gebruik van AI-gegenereerde content te identificeren. Ze worden vaak ingezet door onderwijsinstellingen om plagiaat en academische fraude te voorkomen. Echter, zoals het voorbeeld van de gefrustreerde student laat zien, zijn deze tools niet onfeilbaar. Het is zorgwekkend dat originele werken ten onrechte als AI-gegenereerd kunnen worden gemarkeerd, wat serieuze gevolgen kan hebben voor studenten die valselijk worden beschuldigd van fraude. De gebruiker deed zijn beklag op Reddit.

Waarom Gebeurt Dit?

Er zijn verschillende redenen waarom AI-detectoren fouten maken:

- Algoritmische Beperkingen: AI-detectoren zijn afhankelijk van patronen en statistische modellen om AI-gegenereerde tekst te herkennen. Echter, menselijke schrijfstijlen kunnen soms verrassend veel lijken op de gegenereerde tekst, vooral als ze zeer formeel of gestructureerd zijn.

- Gebrek aan Diversiteit in Trainingsdata: Als de data waarop de detector is getraind niet divers genoeg is, kan dit leiden tot verkeerde classificaties. Teksten die afwijken van de 'norm' van de trainingsdata kunnen sneller als verdacht worden beschouwd.

- Innovatieve Schrijfstijlen: Studenten die unieke en creatieve manieren van schrijven gebruiken, kunnen onbedoeld in de val lopen van deze detectie-algoritmen.

De originele reactie op Reddit

De Impact op Studenten

De gevolgen van valse positieven in AI-detectie kunnen ernstig zijn:

- Onterecht Beschuldigd: Studenten kunnen worden beschuldigd van het gebruik van AI zonder bewijs, wat kan leiden tot stress en mogelijke disciplinaire maatregelen.

- Demotivatie: Herhaaldelijke fouten van deze tools kunnen demotiverend werken voor studenten die hard werken aan hun originele inhoud.

- Verlies van Vertrouwen: Zowel studenten als docenten kunnen het vertrouwen in deze technologie verliezen, wat het doel van AI-detectie ondermijnt.

Wat Kan Er Gedaan Worden?

Om deze problemen aan te pakken, zijn er verschillende stappen die genomen kunnen worden:

- Verbeterde Algoritmen: Ontwikkelaars van AI-detectoren moeten blijven werken aan het verfijnen van hun algoritmen om betrouwbaarder onderscheid te kunnen maken tussen AI-gegenereerde en menselijke teksten.

- Transparantie: Bedrijven die AI-detectietools aanbieden, moeten transparanter zijn over hoe hun algoritmen werken en de beperkingen ervan duidelijk communiceren.

- Menselijke Inbreng: In gevallen van twijfel zou een menselijke controleur de uiteindelijke beslissing moeten nemen in plaats van volledig te vertrouwen op AI.

- Educatie: Studenten en docenten moeten worden onderwezen over de werking en beperkingen van AI-detectietools, zodat ze beter voorbereid zijn om met valse positieven om te gaan.

Lees ook

Conclusie

De ervaring van de student die zijn originele werk ten onrechte als AI-gegenereerd zag gemarkeerd, benadrukt een belangrijk probleem in de huidige staat van AI-detectie. Terwijl technologie blijft evolueren, is het cruciaal dat we de beperkingen ervan erkennen en werken aan oplossingen die eerlijkheid en nauwkeurigheid waarborgen. Alleen dan kunnen we een balans vinden tussen het voorkomen van fraude en het ondersteunen van originele academische prestaties.

Heb jij ook ervaringen met AI-detectietools? Deel je verhaal en laten we samen zoeken naar manieren om deze technologie te verbeteren.

Populair nieuws

Zo maak je je eigen AI-karikatuur met ChatGPT, deze werktrend gaat viraal

Na alle hype vinden sommige AI-experts OpenClaw minder spectaculair

Alibaba brengt nieuw AI-model Qwen3.5 uit

Sam Altman: India telt 100 miljoen wekelijkse ChatGPT-gebruikers

EU opent Frontier AI Grand Challenge om Europees topmodel van 400 miljard parameters te trainen

Bedrijf achter TikTok past de beveiliging van AI-videogenerator Seedance aan na kritiek

Laatste reacties

- fascinerend hoe juist bij Martin (die tegen AI in de rechtszaal staat) de verdenking opduikt.. dat ondermijnt vertrouwen op twee fronten.ai_arjanb11-11-2025

- Waarom geen “safety-by-default” met opt-in voor losser gedrag, plus crisis-detectie en directe verwijzing naar hulpdiensten?martijn_aiz30-10-2025

- voor mij werkt AI het best als snelle “co-pilot” voor analyse, maar de eindbeslissing hoort bij mensen.neuraalnicoy30-10-2025

- Sterk stuk! Dit onderstreept waarom “AI bias” en “betrouwbaarheid van AI” cruciaal zijn voor onderwijs en bedrijfslevenkevinkunstmatigh30-10-2025

- Als D66 de verkenner en mogelijk premier levert, dan wordt de toon technocratisch en pragmatischoptimaliserenotto3230-10-2025

- Interessante scenario-analyse een coalitie met D66, VVD, CDA en JA21 klinkt bestuurbaar, maar ik ben benieuwd hoe ze bruggen slaan op thema’s als stikstof, migratie en klimaatbeleidmachineliefhebber6630-10-2025

- Minder finance studeren dus.victorvirtueel6830-08-2025

- Is dit zoals Midjourney of dall-e?deeplearningdames0330-08-2025

- Google is lekker bezigroosrobotice30-08-2025

- Dit is toch wel kwalijk??intelligenteisa5019-06-2025

Loading