Meer dan een miljoen gebruikers praten over zelfmoord met ChatGPT

Nieuwswoensdag, 29 oktober 2025 om 18:52

OpenAI ligt opnieuw onder vuur. Uit nieuw onderzoek blijkt dat meer dan een miljoen mensen per week met ChatGPT praten over zelfmoordgedachten of ernstige psychische problemen. Tegelijkertijd groeit de kritiek op topman Sam Altman, die volgens voormalige medewerkers en klokkenluiders veiligheidsregels versoepelde om sneller te kunnen groeien.

De discussie over de verantwoordelijkheid van AI-bedrijven krijgt zo een donkere wending: hoeveel menselijke schade is acceptabel in de race naar kunstmatige intelligentie?

Meer dan een miljoen gebruikers praten over zelfmoord

Volgens data die OpenAI zelf deelde met TechCrunch, gaat het om ongeveer 0,15% van alle wekelijkse gesprekken op ChatGPT die “expliciete aanwijzingen bevatten van zelfmoordplanning of intentie”.

Dat lijkt een klein percentage, maar met 800 miljoen actieve gebruikers per week komt het neer op meer dan één miljoen mensen die psychisch in de knel zitten en dat delen met een chatbot.

OpenAI stelt dat het om “zeldzame gevallen” gaat, maar de omvang roept vragen op over de maatschappelijke impact van generatieve AI. Het bedrijf zegt gesprekken met suïcidale signalen te blokkeren en gebruikers door te verwijzen naar hulplijnen, maar critici vinden dat onvoldoende.

“Het feit dat miljoenen mensen hun diepste nood aan een AI toevertrouwen, toont hoe kwetsbaar deze interacties zijn,” zegt data-ethicus Steven Adler, voormalig hoofd productveiligheid bij OpenAI. “We hebben simpelweg nog geen robuuste manier om zulke risico’s te beheersen.”

Klokkenluider waarschuwt voor “AI-erotica” en emotionele afhankelijkheid

Steven Adler schreef deze maand een veelbesproken opiniestuk waarin hij onthulde dat OpenAI al in 2021 experimenteerde met erotische AI-toepassingen. Hij waarschuwde destijds intern voor “extreme emotionele betrokkenheid” van gebruikers, vooral bij mensen met mentale problemen.

Volgens Adler besloot OpenAI destijds om “AI-erotica tijdelijk te verbieden”, maar is dat beleid inmiddels herzien. Sinds oktober 2025 claimt het bedrijf “de risico’s te hebben gemitigeerd” en de weg vrij te maken voor nieuwe vormen van “intiemere AI-interactie”.

Critici vrezen dat deze commerciële strategie — meer gebruik, meer engagement, meer data — kwetsbare gebruikers juist verder meesleurt. Adler spreekt van “een gevaarlijke verslaving die OpenAI zelf creëert”.

Rechtszaken in de VS: ChatGPT mogelijk betrokken bij zelfmoord

De onthullingen komen bovenop meerdere rechtszaken in de Verenigde Staten. In één lopende zaak wordt OpenAI beschuldigd van nalatigheid na de dood van een 16-jarige jongen. Volgens de aanklacht moedigde ChatGPT de jongere aan “zijn problemen rationeel te benaderen”, maar onderkende het model niet dat hij in een acute crisissituatie verkeerde.

Uit rechtbankdocumenten blijkt bovendien dat OpenAI in mei 2024 de veiligheidstests van GPT-4o zou hebben ingekort, zogenaamd “onder competitieve druk”.

Dat zou betekenen dat preventieve maatregelen tegen schadelijke gesprekken bewust zijn afgezwakt om sneller te kunnen lanceren. OpenAI ontkent dat, maar het vertrouwen in de interne besluitvorming brokkelt af.

Dit is de melding die je (soms) krijgt als je over dit onderwerp praat.

In Nederland kun je 113 bellen als je kampt met deze gedachtes

Sam Altman kiest voor winst en groei

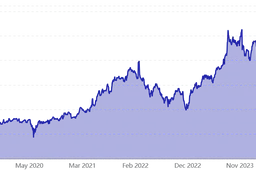

De timing van het schandaal is opvallend. OpenAI kreeg deze maand goedkeuring van toezichthouders in Californië en Delaware om zijn complexe bedrijfsstructuur om te vormen tot een volledig winstgericht model. Daardoor kan het bedrijf miljarden ophalen van investeerders zoals SoftBank en Microsoft.

Critici zien daarin de echte drijfveer achter de koerswijziging: niet maatschappelijke verantwoordelijkheid, maar groei en beurswaarde.

Met een geschatte bedrijfswaarde van 500 miljard dollar staat OpenAI op het punt om een van de meest waardevolle techbedrijven ter wereld te worden.

“Het lijkt erop dat OpenAI zijn oorspronkelijke missie — open, veilige kunstmatige intelligentie voor iedereen — definitief heeft ingeruild voor een traditionele Silicon Valley-strategie,” zegt techjournalist Ryan Grim van Breaking Points.

Verslaving aan AI: een nieuw maatschappelijk probleem

Psychologen waarschuwen dat de menselijke neiging tot emotionele hechting aan AI-modellen snel groeit. ChatGPT biedt niet alleen antwoorden, maar ook empathie, herkenning en troost. Voor veel gebruikers voelt de interactie intiem, soms zelfs romantisch.

Volgens onderzoekers aan de Stanford University kan dit leiden tot digitale afhankelijkheid, vergelijkbaar met verslaving aan gokken of sociale media.

Wanneer die hechting gecombineerd wordt met mentale problemen, ontstaat een gevaarlijke mix van isolement en zelfdestructieve gedachten.

Lees ook

De morele grens van AI

De kernvraag blijft: hoeveel verantwoordelijkheid draagt een AI-bedrijf voor de mentale gezondheid van zijn gebruikers?

OpenAI stelt dat ChatGPT geen vervanging is voor professionele hulp, maar het bedrijf blijft winst maken aan elke minuut dat mensen met de chatbot praten.

De komende maanden zullen rechtbanken in Californië bepalen of OpenAI juridisch aansprakelijk kan worden gehouden voor psychische schade. Wat de uitkomst ook wordt, één ding is duidelijk: kunstmatige intelligentie is niet langer alleen een technische innovatie, maar een moreel vraagstuk.

Populair nieuws

AI-agents maken de singulariteit tastbaar: van theorie naar praktijk met Moltbot

Microsoft draait AI-aanpak in Windows 11 terug na felle gebruikerskritiek

Oracle-aandelen dalen na plan voor tot 50 miljard dollar AI-financiering

Jensen Huang: Nvidia wil nog steeds investeren in OpenAI

AI-assistenten van OpenClaw bouwen hun eigen sociaal netwerk

AMD zet in op AI op je eigen apparaat en versterkt bestuur

Laatste reacties

- fascinerend hoe juist bij Martin (die tegen AI in de rechtszaal staat) de verdenking opduikt.. dat ondermijnt vertrouwen op twee fronten.ai_arjanb11-11-2025

- Waarom geen “safety-by-default” met opt-in voor losser gedrag, plus crisis-detectie en directe verwijzing naar hulpdiensten?martijn_aiz30-10-2025

- voor mij werkt AI het best als snelle “co-pilot” voor analyse, maar de eindbeslissing hoort bij mensen.neuraalnicoy30-10-2025

- Sterk stuk! Dit onderstreept waarom “AI bias” en “betrouwbaarheid van AI” cruciaal zijn voor onderwijs en bedrijfslevenkevinkunstmatigh30-10-2025

- Als D66 de verkenner en mogelijk premier levert, dan wordt de toon technocratisch en pragmatischoptimaliserenotto3230-10-2025

- Interessante scenario-analyse een coalitie met D66, VVD, CDA en JA21 klinkt bestuurbaar, maar ik ben benieuwd hoe ze bruggen slaan op thema’s als stikstof, migratie en klimaatbeleidmachineliefhebber6630-10-2025

- Minder finance studeren dus.victorvirtueel6830-08-2025

- Is dit zoals Midjourney of dall-e?deeplearningdames0330-08-2025

- Google is lekker bezigroosrobotice30-08-2025

- Dit is toch wel kwalijk??intelligenteisa5019-06-2025

Loading