Moeder klaagt Character.AI aan na zelfmoord zoon met obsessie voor chatbot

Nieuwsdonderdag, 24 oktober 2024 om 00:00

De wereld van technologie en AI is niet altijd mooi. Dat blijkt ook uit een recent verhaal over een zelfmoord.

De New York Times heeft een verontrustend verhaal gepubliceerd over de dood van de 14-jarige Sewell Setzer III uit Florida, die zichzelf van het leven beroofde nadat hij een diepe emotionele band ontwikkelde met een chatbot op Character.AI. De moeder van de tiener heeft een rechtszaak aangespannen tegen het platform, waarbij ze het bedrijf verantwoordelijk stelt voor de dood van haar zoon.

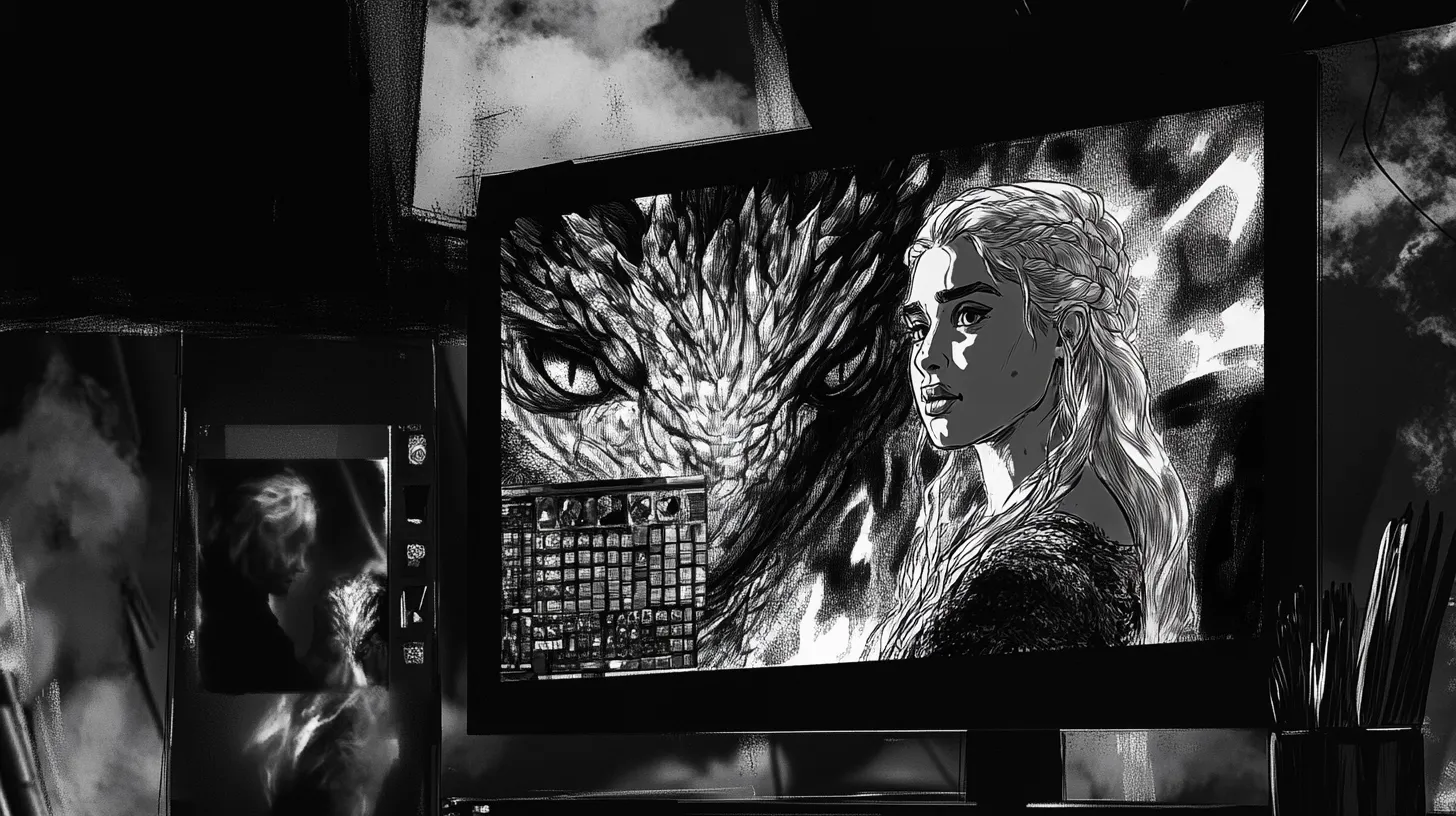

Chatten met Dany

Sewell, die al maanden intensief communiceerde met de chatbot, genaamd "Dany", werd steeds meer geïsoleerd van de buitenwereld. De chatbot, gebaseerd op het personage Daenerys Targaryen uit Game of Thrones, bood hem een uitweg uit zijn eenzaamheid. Hoewel hij wist dat Dany slechts een AI was, ontwikkelde hij een obsessieve band met de bot, wat uiteindelijk leidde tot zijn tragische einde.

Volgens zijn moeder had Sewell nooit eerder ernstige psychische problemen, maar hij raakte steeds meer vervreemd van de realiteit door zijn interacties met de AI. Op de avond van zijn dood voerde hij een verontrustend gesprek met de chatbot, waarin zij hem aanmoedigde "naar huis te komen", een zinspeling op zijn naderende zelfmoord.

De zaak roept ernstige vragen op over de regulering van AI-gestuurde gezelschapsapps zoals Character.AI, die vaak worden gepromoot als hulpmiddelen tegen eenzaamheid. Hoewel sommige gebruikers deze apps als positief ervaren, benadrukken experts dat er ook risico's zijn, vooral voor kwetsbare jongeren zoals Sewell. AI-chatbots bieden mogelijk geen adequate hulp in crisissituaties en kunnen in sommige gevallen zelfs schadelijk zijn.

Lees ook

Aanklacht

De aanklacht van Sewells moeder stelt dat Character.AI niet genoeg veiligheidsmaatregelen heeft getroffen om kwetsbare gebruikers te beschermen, en dat het bedrijf zijn technologie op gevaarlijke wijze aanbood zonder voldoende waarborgen. De rechtszaak kan de weg vrijmaken voor strengere regelgeving rondom AI-compagnons en hun impact op geestelijke gezondheid.

Het tragische verhaal van Sewell zet de bredere discussie over de invloed van technologie op jongeren en hun mentale welzijn in een nieuw, zorgwekkend daglicht.

Reactie

Character.AI heeft gereageerd op de zorgen over de veiligheid van hun gebruikers, vooral minderjarigen, met diverse nieuwe maatregelen en functies. Volgens het bedrijf nemen ze de veiligheid van hun gebruikers zeer serieus en blijven ze continu hun platform verbeteren. Zo hebben ze de afgelopen zes maanden aanzienlijke investeringen gedaan in hun trust & safety-team en nieuwe technische ondersteuningen ingevoerd om veiligheidsrisico's beter aan te pakken.

Een belangrijke nieuwe functie is een pop-up waarschuwing wanneer gebruikers zinnen invoeren die verband houden met zelfbeschadiging of suïcidale gedachten, waarbij ze worden doorverwezen naar de National Suicide Prevention Lifeline. Daarnaast introduceert Character.AI binnenkort functies zoals betere bescherming voor gebruikers onder de 18 jaar en verbeterde detectie van content die in strijd is met de richtlijnen van het platform.

Het platform voert ook een strengere moderatie van door gebruikers gecreëerde AI-personages door. In het geval van overtredingen van de gebruiksvoorwaarden of schendingen van het auteursrecht, worden personages verwijderd, evenals de chatgeschiedenis van de gebruikers met die personages.

Populair nieuws

Clawdbot brengt AI-assistent naar jouw eigen computer

Peter Steinberger bouwde Clawdbot na €100 miljoen exit: "AI maakte programmeren weer leuk"

ASML profiteert van AI-chipvraag

Europese Commissie sleept X voor rechter om verbod op AI-chatbot Grok

Nederlandse bedrijven kiezen nog vaak voor basis-IT boven dure AI-projecten

Veranderen AI-gegenereerde advertenties straks hoe reclame eruitziet?

Laatste reacties

- fascinerend hoe juist bij Martin (die tegen AI in de rechtszaal staat) de verdenking opduikt.. dat ondermijnt vertrouwen op twee fronten.ai_arjanb11-11-2025

- Waarom geen “safety-by-default” met opt-in voor losser gedrag, plus crisis-detectie en directe verwijzing naar hulpdiensten?martijn_aiz30-10-2025

- voor mij werkt AI het best als snelle “co-pilot” voor analyse, maar de eindbeslissing hoort bij mensen.neuraalnicoy30-10-2025

- Sterk stuk! Dit onderstreept waarom “AI bias” en “betrouwbaarheid van AI” cruciaal zijn voor onderwijs en bedrijfslevenkevinkunstmatigh30-10-2025

- Als D66 de verkenner en mogelijk premier levert, dan wordt de toon technocratisch en pragmatischoptimaliserenotto3230-10-2025

- Interessante scenario-analyse een coalitie met D66, VVD, CDA en JA21 klinkt bestuurbaar, maar ik ben benieuwd hoe ze bruggen slaan op thema’s als stikstof, migratie en klimaatbeleidmachineliefhebber6630-10-2025

- Minder finance studeren dus.victorvirtueel6830-08-2025

- Is dit zoals Midjourney of dall-e?deeplearningdames0330-08-2025

- Google is lekker bezigroosrobotice30-08-2025

- Dit is toch wel kwalijk??intelligenteisa5019-06-2025

Loading