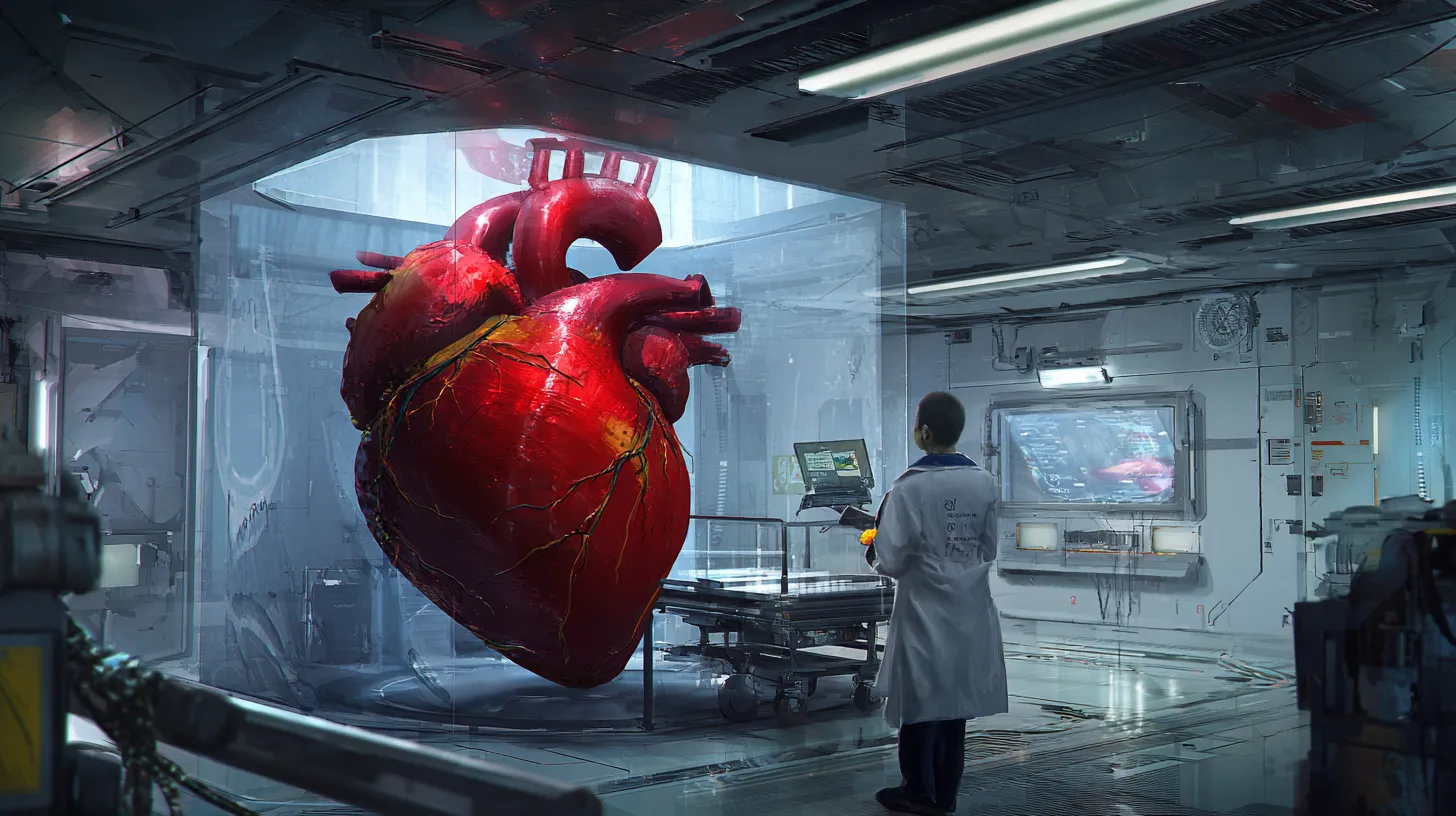

Universiteiten omzeilen ethische toetsing met AI-gegenereerde medische data

Nieuwszondag, 14 september 2025 om 13:04

AI-modellen creëren synthetische patiëntdata die onderzoekers gebruiken zonder toestemming van ethische commissies. Internationale universiteiten verdedigen deze werkwijze, maar experts waarschuwen voor risico’s.

Meerdere vooraanstaande medische onderzoekscentra in Canada, de Verenigde Staten en Italië maken gebruik van synthetische medische data die zijn gegenereerd door kunstmatige intelligentie (AI), zónder deze voor te leggen aan een ethische toetsingscommissie.

De instellingen claimen dat de data geen echte of herleidbare patiëntinformatie bevatten en daarmee buiten de standaardregels vallen. Dat is te lezen bij Nature.

Wat zijn synthetische medische data precies?

Onderzoekers trainen zogeheten generatieve AI-modellen op bestaande medische dossiers en laten deze vervolgens nieuwe datasets genereren die statistisch lijken op echte data, maar die geen individuele patiëntgegevens bevatten. Dit synthetisch gegenereerde materiaal wordt vervolgens ingezet in wetenschappelijk onderzoek.

Onderzoek zonder ethische goedkeuring

Volgens vertegenwoordigers van onder meer het Children’s Hospital of Eastern Ontario (CHEO), het Ottawa Hospital, de IRCCS Humanitas Research Hospital in Milaan en Washington University School of Medicine is voor dergelijk onderzoek geen ethische goedkeuring vereist. De reden: de gebruikte data vallen niet onder de definitie van ‘persoonlijke gezondheidsinformatie’ of ‘onderzoek met menselijke proefpersonen’.

Philip Payne, vicekanselier voor biomedische informatica aan Washington University, legt uit dat hun ethische commissie sinds 2020 geen beoordeling meer uitvoert op onderzoek met synthetische datasets. “De Amerikaanse wetgeving uit 1991 beschouwt dit niet als onderzoek met menselijke proefpersonen, omdat de gegevens niet herleidbaar zijn tot echte personen,” aldus Payne.

Versnelling van medisch onderzoek

Volgens Khaled El Emam, AI-onderzoeker bij CHEO en de Universiteit van Ottawa, maakt deze aanpak het mogelijk om sneller onderzoek uit te voeren, zonder het risico op privacyproblemen. “Je hoeft niet langer te wachten op toestemming of juridische obstakels bij datadeling tussen instellingen. Dit bespaart tijd en vergroot de efficiëntie.”

Ook in Italië ziet men voordelen. Humanitas AI-teamleider Saverio D’Amico benadrukt dat hun status als toonaangevend onderzoeksziekenhuis hen meer vrijheid biedt dan andere instellingen. “Zolang patiënten vooraf toestemming geven voor het gebruik van hun data voor AI-doeleinden, kunnen wij synthetische versies ervan gebruiken zonder nieuwe goedkeuring aan te vragen.”

Kritische kanttekeningen en juridische nuances

Toch is de praktijk niet zonder controverse. In Canada bijvoorbeeld bepalen de Personal Health Information Protection Act en juridische analyses uit 2024 dat synthetische data buiten het bereik van persoonlijke gezondheidswetgeving vallen. Maar zodra onderzoekers toegang nodig hebben tot de oorspronkelijke patiëntdata om de synthetische variant te genereren, is er wél toestemming van een ethische commissie vereist.

Cécile Bensimon, voorzitter van de ethische commissie van CHEO, erkent dit onderscheid. “Het creëren van synthetische data uit patiëntendossiers vereist nog steeds goedkeuring. Maar zulke aanvragen worden meestal als laag-risico beschouwd, wat het mogelijk maakt om de geïnformeerde toestemming van patiënten te omzeilen.”

Mogelijke gevaren: bias en transparantie

Hoewel de voordelen evident zijn, waarschuwen sommige experts voor risico’s zoals AI-bias (vooroordelen in data), gebrek aan transparantie en het juridisch gladde ijs waarop instellingen zich begeven. Synthetische data mogen dan anoniem zijn, maar fouten in de trainingsdata kunnen leiden tot vertekende uitkomsten die in de praktijk gevolgen hebben voor medische beslissingen.

Conclusie: pragmatiek of principieel probleem?

De inzet van synthetische data versnelt wetenschappelijk onderzoek en beschermt de privacy van patiënten, stellen voorstanders. Toch roept de ethische omzeiling fundamentele vragen op over transparantie, wetenschappelijke integriteit en de grenzen van AI in de gezondheidszorg. Wat vandaag als ‘veilig’ geldt, kan morgen ethisch problematisch blijken.

Populair nieuws

AI-agents maken de singulariteit tastbaar: van theorie naar praktijk met Moltbot

Microsoft draait AI-aanpak in Windows 11 terug na felle gebruikerskritiek

Oracle-aandelen dalen na plan voor tot 50 miljard dollar AI-financiering

Jensen Huang: Nvidia wil nog steeds investeren in OpenAI

AI-assistenten van OpenClaw bouwen hun eigen sociaal netwerk

AMD zet in op AI op je eigen apparaat en versterkt bestuur

Laatste reacties

- fascinerend hoe juist bij Martin (die tegen AI in de rechtszaal staat) de verdenking opduikt.. dat ondermijnt vertrouwen op twee fronten.ai_arjanb11-11-2025

- Waarom geen “safety-by-default” met opt-in voor losser gedrag, plus crisis-detectie en directe verwijzing naar hulpdiensten?martijn_aiz30-10-2025

- voor mij werkt AI het best als snelle “co-pilot” voor analyse, maar de eindbeslissing hoort bij mensen.neuraalnicoy30-10-2025

- Sterk stuk! Dit onderstreept waarom “AI bias” en “betrouwbaarheid van AI” cruciaal zijn voor onderwijs en bedrijfslevenkevinkunstmatigh30-10-2025

- Als D66 de verkenner en mogelijk premier levert, dan wordt de toon technocratisch en pragmatischoptimaliserenotto3230-10-2025

- Interessante scenario-analyse een coalitie met D66, VVD, CDA en JA21 klinkt bestuurbaar, maar ik ben benieuwd hoe ze bruggen slaan op thema’s als stikstof, migratie en klimaatbeleidmachineliefhebber6630-10-2025

- Minder finance studeren dus.victorvirtueel6830-08-2025

- Is dit zoals Midjourney of dall-e?deeplearningdames0330-08-2025

- Google is lekker bezigroosrobotice30-08-2025

- Dit is toch wel kwalijk??intelligenteisa5019-06-2025

Loading