Nieuwe benchmark onthult opvallende resultaten: Kimi K2 Thinking en GPT-OSS-120B verrassen

Nieuwszondag, 09 november 2025 om 15:24

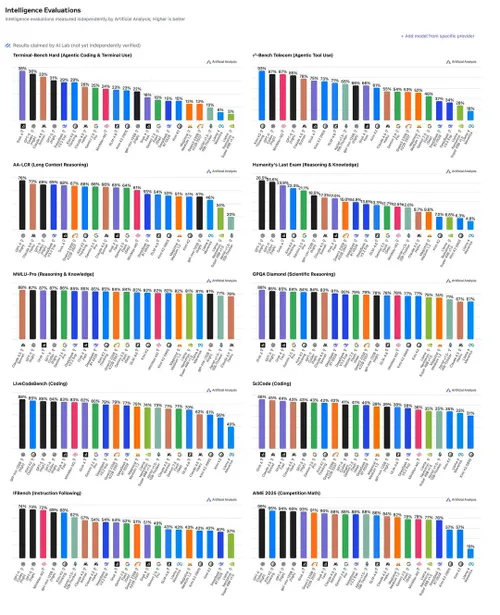

Het onafhankelijke onderzoeksplatform Artificial Analysis heeft een uitgebreid nieuw overzicht gepubliceerd van de prestaties van toonaangevende AI-modellen, waaronder Kimi K2 Thinking, GPT-5 Pro, Claude 3.5 Sonnet, Gemini 1.5 Pro en diverse open-source modellen. De benchmark vergelijkt de modellen op uiteenlopende taken zoals redeneren, coderen en wetenschappelijke kennis.

Kimi K2 Thinking scoort sterk op redenering

Volgens de nieuwe cijfers behoort Kimi K2 Thinking tot de hoogst scorende modellen in redeneringstests zoals AA-LCR (Long Context Reasoning) en Humanity’s Last Exam. Het model behaalt scores tussen de 70 en 80 procent en laat daarmee gevestigde namen als Claude 3.5 Sonnet en Gemini 1.5 Pro achter zich op specifieke onderdelen.

Artificial Analysis beschrijft deze tests als maatstaven voor “intelligentie en redeneervermogen op menselijk niveau”. In de grafieken is te zien dat de topmodellen van Anthropic, OpenAI en Moonshot AI (de maker van Kimi) dicht bij elkaar liggen, wat wijst op een hevige concurrentiestrijd aan de top van de AI-industrie.

GPT-OSS-120B opvallend goed in codering

Wat vooral de aandacht trekt, is de positie van GPT-OSS-120B, een open-source model dat volgens de LiveCodeBench-test momenteel het best presterende coderingsmodel ter wereld zou zijn. Het model scoort hoger dan commerciële giganten als GPT-4o, Claude 3.5 Sonnet en Gemini 1.5 Pro.

Die uitkomst zorgt voor verbazing in de online community. Een Reddit-gebruiker reageerde met humor: “So GPT-OSS-120B is the best coder in the world now?” Een ander merkte op dat het model weliswaar goedkoop is, maar dat bijna niemand het daadwerkelijk gebruikt voor programmeertaken.

Twijfels over betrouwbaarheid van benchmarks

Niet iedereen neemt de resultaten voor waar aan. Meerdere reacties plaatsen vraagtekens bij de methodologie van Artificial Analysis. Een gebruiker schreef: “Their scores have been really disconnected from user sentiment and real-world results.”

Een ander vermoedt dat de hoge score van GPT-OSS-120B het gevolg is van specifieke training: “Trained heavy on that dataset, I bet.” Daarmee wordt gesuggereerd dat het model mogelijk is geoptimaliseerd voor de exacte taken waarop het wordt getest.

GPT-5 Pro en Claude 3.5 blijven consistent

Hoewel de open-source modellen opvallend presteren in sommige categorieën, blijven GPT-5 Pro en Claude 3.5 Sonnet gemiddeld gezien de meest consistente modellen. Ze scoren stabiel boven de 80 procent op vrijwel alle benchmarks, waaronder MMLU-Pro (kennis en redenering) en GPOA Diamond (wetenschappelijke logica).

Opvallend is dat OpenAI’s GPT-5 Pro de hoogste score haalt op AIME 2025 (Competition Math), een benchmark gebaseerd op wiskundige olympiades, met bijna 100 procent accuraatheid.

Lees ook

Toenemende diversiteit in AI-modellen

De publicatie van Artificial Analysis benadrukt hoe breed het veld van geavanceerde taalmodellen inmiddels is geworden. Waar voorheen OpenAI de standaard bepaalde, laten de resultaten zien dat Chinese bedrijven zoals Moonshot AI (Kimi), maar ook open-source initiatieven, steeds dichter bij de top komen.

Het feit dat er nu tientallen modellen worden vergeleken op verschillende domeinen – van codering tot wetenschappelijke redenering – toont aan dat de AI-markt snel volwassen wordt.

Populair nieuws

iPhone 17e lijkt binnenkort te verschijnen met A19-chip en MagSafe

OpenAI rolt geavanceerde Deep Research-viewer uit in ChatGPT

Rabobank waarschuwt voor Amerikaanse AI-afhankelijkheid

AI onthult Romeins bordspel in museum Heerlen

Roland Busch waarschuwt voor AI-silo’s en wil met Siemens “alles automatiseren”

Macron reist naar India voor top over kunstmatige intelligentie

Laatste reacties

- fascinerend hoe juist bij Martin (die tegen AI in de rechtszaal staat) de verdenking opduikt.. dat ondermijnt vertrouwen op twee fronten.ai_arjanb11-11-2025

- Waarom geen “safety-by-default” met opt-in voor losser gedrag, plus crisis-detectie en directe verwijzing naar hulpdiensten?martijn_aiz30-10-2025

- voor mij werkt AI het best als snelle “co-pilot” voor analyse, maar de eindbeslissing hoort bij mensen.neuraalnicoy30-10-2025

- Sterk stuk! Dit onderstreept waarom “AI bias” en “betrouwbaarheid van AI” cruciaal zijn voor onderwijs en bedrijfslevenkevinkunstmatigh30-10-2025

- Als D66 de verkenner en mogelijk premier levert, dan wordt de toon technocratisch en pragmatischoptimaliserenotto3230-10-2025

- Interessante scenario-analyse een coalitie met D66, VVD, CDA en JA21 klinkt bestuurbaar, maar ik ben benieuwd hoe ze bruggen slaan op thema’s als stikstof, migratie en klimaatbeleidmachineliefhebber6630-10-2025

- Minder finance studeren dus.victorvirtueel6830-08-2025

- Is dit zoals Midjourney of dall-e?deeplearningdames0330-08-2025

- Google is lekker bezigroosrobotice30-08-2025

- Dit is toch wel kwalijk??intelligenteisa5019-06-2025

Loading