Wie herkent AI-gegenereerde teksten beter? AI versus mens in de medische wereld

Blogdonderdag, 06 juni 2024 om 16:30

Wie kan het beste artikelen en teksten herkennen die zijn geschreven met behulp van AI? Deze vraag probeerde onderzoekers te beantwoorden.

In het artikel "The great detectives: humans versus AI detectors in catching large language model-generated medical writing," gepubliceerd in de International Journal for Educational Integrity, wordt de strijd tussen mens en machine onderzocht in het detecteren van door AI gegenereerde medische teksten.

Onderzoeksdoelen en methoden

Het onderzoek richtte zich op twee hoofddoelen:

- Evaluatie van AI-detectoren: Testen van tools zoals Originality.ai om hun nauwkeurigheid te beoordelen bij het identificeren van AI-gegenereerde teksten.

- Menselijke Reviewers: Analyse van de prestaties van menselijke reviewers, waaronder professoren en studenten, bij het onderscheiden van door AI en mens geschreven teksten.

De onderzoekers maakten gebruik van een dataset met zowel originele als geparafraseerde teksten, gegenereerd door geavanceerde taalmodellen. Deze teksten werden vervolgens geanalyseerd door zowel AI-detectoren als menselijke reviewers.

Belangrijkste bevindingen

- AI-Detectoren:Originality.ai behaalde indrukwekkende resultaten met een nauwkeurigheid van 100% in het detecteren van door AI gegenereerde teksten. Dit omvatte zowel originele als licht aangepaste teksten.

- Menselijke Reviewers:Professoren versus Studenten: Professoren presteerden over het algemeen beter dan studenten in het correct identificeren van door AI geschreven teksten. Echter, een opvallende fout was dat menselijke reviewers vaak menselijke teksten verkeerd identificeerden als door AI gegenereerd.Misclassificatie: Dit wijst op de complexiteit en subtiliteit van AI-gegenereerde teksten die soms te goed zijn om gemakkelijk te onderscheiden van menselijke schrijfwerken.

Om een idee te geven van hoe de onderzoekers te werk gingen, zie je hieronder een uiteenzetting van hoe het in de praktijk werd onderzocht:

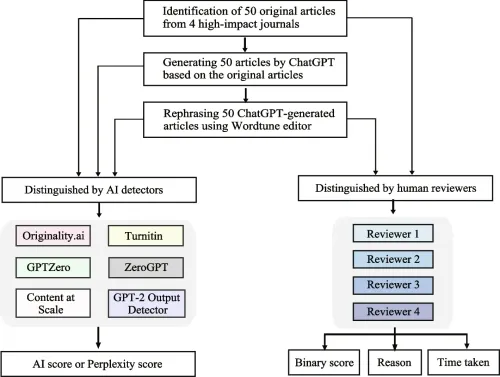

- Stadia van het onderzoek:Selectie van papers: 50 gepubliceerde, peer-reviewed artikelen uit vier vooraanstaande tijdschriften werden geïdentificeerd.Generatie van kunstmatige papers: Papers werden gegenereerd met behulp van ChatGPT.Herschrijven: De door ChatGPT gegenereerde papers werden herschreven met een parafraseertool genaamd Wordtune.AI detectie: Zes AI-contentdetectoren werden ingezet om de originele papers, ChatGPT-gegenereerde papers en AI-herschreven papers te onderscheiden.

- Menselijke beoordeling: Vier reviewers beoordeelden en evalueerden de originele en AI-herschreven papers om hun vermogen te testen om deze te onderscheiden

Dat ziet er dan ongeveer zo uit:

Implicaties en toekomstige richtingen

De resultaten van dit onderzoek hebben belangrijke implicaties voor de academische wereld en uitgevers van medische literatuur:

- Noodzaak van Geavanceerde Tools: De bevindingen onderstrepen de behoefte aan geavanceerde AI-detectietools binnen academische instellingen om plagiaat en oneigenlijk gebruik van AI te voorkomen.

- Training van Reviewers: Er is een duidelijke behoefte aan training en bewustwording bij menselijke reviewers om hun vaardigheden in het herkennen van AI-gegenereerde inhoud te verbeteren.

Het onderzoek benadrukt de kracht van geavanceerde AI-detectoren zoals Originality.ai en de waarde van ervaren menselijke reviewers. Beide spelen een cruciale rol in het waarborgen van de integriteit van academische publicaties. Naarmate AI-modellen zich verder ontwikkelen, zal de combinatie van technologische oplossingen en menselijke expertise essentieel blijven om de kwaliteit en betrouwbaarheid van wetenschappelijke literatuur te handhaven. Meer van het onderzoek vind je hier.

Lees ook

Populair nieuws

Zo maak je je eigen AI-karikatuur met ChatGPT, deze werktrend gaat viraal

Na alle hype vinden sommige AI-experts OpenClaw minder spectaculair

Alibaba brengt nieuw AI-model Qwen3.5 uit

Sam Altman: India telt 100 miljoen wekelijkse ChatGPT-gebruikers

EU opent Frontier AI Grand Challenge om Europees topmodel van 400 miljard parameters te trainen

Tekort aan geheugenchips drukt op volgende generatie games

Laatste reacties

- fascinerend hoe juist bij Martin (die tegen AI in de rechtszaal staat) de verdenking opduikt.. dat ondermijnt vertrouwen op twee fronten.ai_arjanb11-11-2025

- Waarom geen “safety-by-default” met opt-in voor losser gedrag, plus crisis-detectie en directe verwijzing naar hulpdiensten?martijn_aiz30-10-2025

- voor mij werkt AI het best als snelle “co-pilot” voor analyse, maar de eindbeslissing hoort bij mensen.neuraalnicoy30-10-2025

- Sterk stuk! Dit onderstreept waarom “AI bias” en “betrouwbaarheid van AI” cruciaal zijn voor onderwijs en bedrijfslevenkevinkunstmatigh30-10-2025

- Als D66 de verkenner en mogelijk premier levert, dan wordt de toon technocratisch en pragmatischoptimaliserenotto3230-10-2025

- Interessante scenario-analyse een coalitie met D66, VVD, CDA en JA21 klinkt bestuurbaar, maar ik ben benieuwd hoe ze bruggen slaan op thema’s als stikstof, migratie en klimaatbeleidmachineliefhebber6630-10-2025

- Minder finance studeren dus.victorvirtueel6830-08-2025

- Is dit zoals Midjourney of dall-e?deeplearningdames0330-08-2025

- Google is lekker bezigroosrobotice30-08-2025

- Dit is toch wel kwalijk??intelligenteisa5019-06-2025

Loading