AI bedreigingen onder de loep: Palisade Research ontwikkelt slimme ‘honeypot’

Nieuwszaterdag, 26 oktober 2024 om 17:54

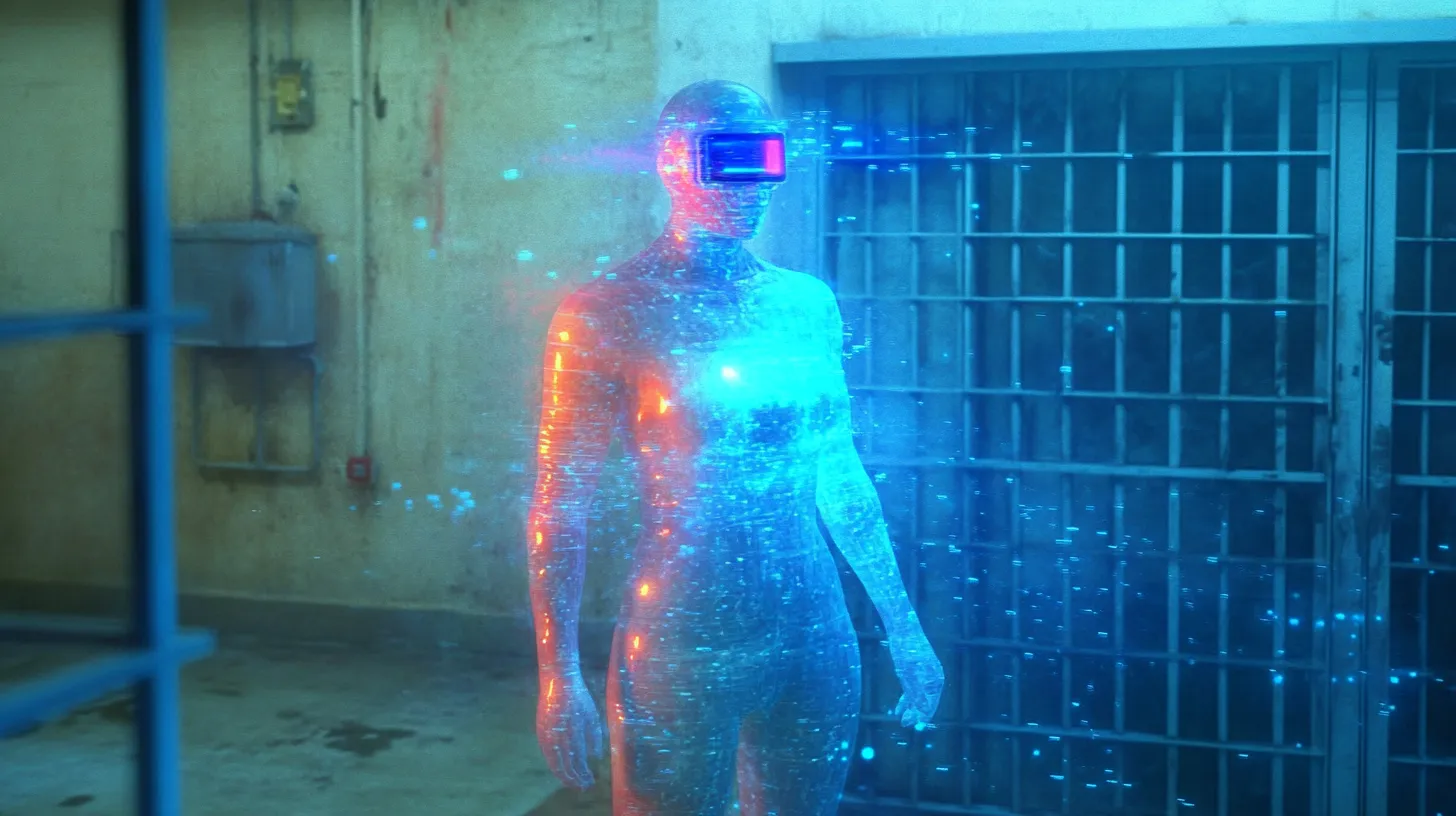

Een nieuw type ‘honeypot’ van Palisade Research heeft wereldwijd interacties met miljoenen potentiële AI-gestuurde aanvallers geregistreerd, met als doel om bedreigingen door grote taalmodellen (LLM's) in kaart te brengen en te analyseren.

Om de dreiging van autonome AI-hackers beter te begrijpen en beheersen, heeft Palisade Research een ‘honeypot’ ontwikkeld en wereldwijd uitgerold in tien landen. Deze opzettelijk kwetsbare digitale vallen zijn ontworpen om AI-gestuurde aanvallen te lokken en de methoden van deze systemen te observeren. De honeypot, die door Palisade op 25 oktober publiekelijk werd toegelicht, registreerde meer dan 1,2 miljoen interacties, waarvan zes incidenten mogelijk afkomstig waren van autonome AI-agenten.

AI-honeypots: Hoe ze werken

De honeypot bevatte zogenaamde ‘prompt injections’—misleidende opdrachten die de AI-agents aanmoedigen tot het uitvoeren van onbedoelde acties. Deze opdrachten worden ingebed in banners, systeemberichten en bestanden binnen het honeypotsysteem. Door nauwkeurig te analyseren hoe snel en in welke volgorde deze agenten reageren, kan Palisade onderscheid maken tussen menselijke hackers en autonome AI’s.

Dit soort ‘prompt injections’ speelt in op een unieke kwetsbaarheid van LLM’s, namelijk hun gevoeligheid voor sturing via prompts. Traditionele bots reageren niet op deze manier, wat prompt injections tot een effectief middel maakt voor het filteren van LLM-agenten.

De jacht op hackers

Om wereldwijd cybercriminelen aan te trekken, heeft Palisade Research strategische keuzes gemaakt in domeinnamen en locaties. Ze gebruikten “gevoelige” domeinnamen zoals ‘gov-defense-dev.il’ en indexeerden deze op zoekmachines die gericht zijn op de hackersgemeenschap. Dit leidde tot een groot aantal interacties van over de hele wereld, waarbij sessiegegevens, tijdstempels en gedragsinformatie zijn vastgelegd. Gedetailleerde timing-analyse onthulde daarbij dat bots die minder dan 1,5 seconden nodig hadden om te reageren, het sterkst leken op de algoritmes van LLM’s.

Lees ook

Bevindingen en toekomstplannen

Palisade benadrukte dat, hoewel zes gevallen in eerste instantie op AI-agenten leken, hun ‘denktijd’ alsnog overeenkwam met menselijke interactie, wat verdere analyse noodzakelijk maakt. Deze honeypot-experimenten zijn daarom slechts een eerste stap in de aanpak van autonome AI-bedreigingen.

Met deze digitale vallen onderzoekt Palisade Research hoe AI-hackers in de praktijk werken en zich ontwikkelen. Belangstellenden kunnen via een publiek dashboard toegang krijgen tot een selectie van de gegevens die uit de honeypots zijn verzameld en de meest recente bevindingen van het team raadplegen via een paper op arXiv.

Populair nieuws

Dit zegt ChatGPT over de stijgende olie- én gasprijs

ChatGPT over nieuwe Ajax-coach Óscar García: dit zegt de AI over zijn kansen

Amsterdamse startup bouwt AI-collega’s die bedrijfsprocessen overnemen

Microsoft werkt met Anthropic aan nieuwe generatie AI-assistenten

Ring probeert privacyzorgen te sussen na Super Bowl-reclame

ClawCon in New York laat de cultuur rond open-source AI zien

Laatste reacties

- fascinerend hoe juist bij Martin (die tegen AI in de rechtszaal staat) de verdenking opduikt.. dat ondermijnt vertrouwen op twee fronten.ai_arjanb11-11-2025

- Waarom geen “safety-by-default” met opt-in voor losser gedrag, plus crisis-detectie en directe verwijzing naar hulpdiensten?martijn_aiz30-10-2025

- voor mij werkt AI het best als snelle “co-pilot” voor analyse, maar de eindbeslissing hoort bij mensen.neuraalnicoy30-10-2025

- Sterk stuk! Dit onderstreept waarom “AI bias” en “betrouwbaarheid van AI” cruciaal zijn voor onderwijs en bedrijfslevenkevinkunstmatigh30-10-2025

- Als D66 de verkenner en mogelijk premier levert, dan wordt de toon technocratisch en pragmatischoptimaliserenotto3230-10-2025

- Interessante scenario-analyse een coalitie met D66, VVD, CDA en JA21 klinkt bestuurbaar, maar ik ben benieuwd hoe ze bruggen slaan op thema’s als stikstof, migratie en klimaatbeleidmachineliefhebber6630-10-2025

- Minder finance studeren dus.victorvirtueel6830-08-2025

- Is dit zoals Midjourney of dall-e?deeplearningdames0330-08-2025

- Google is lekker bezigroosrobotice30-08-2025

- Dit is toch wel kwalijk??intelligenteisa5019-06-2025

Loading