LM Arena vernieuwt scoremethode: snellere berekening en eerlijkere ranglijsten

Nieuwsmaandag, 28 juli 2025 om 21:11

LMArena, het bekende platform voor het vergelijken van AI-modellen op basis van menselijke voorkeuren, heeft een belangrijke wijziging doorgevoerd in de manier waarop scores en ranglijsten tot stand komen. Dankzij een nieuw rekenmodel op basis van de centrale limietstelling (CLT) kunnen scores nu sneller en nauwkeuriger worden berekend, mét behoud van statistische betrouwbaarheid.

Van bootstrapping naar closed-form berekening

Tot voor kort gebruikte LMArena zogeheten bootstrapping om de onzekerheidsmarges (confidence intervals) van scores te berekenen. Dit statistische proces herhaalt dezelfde steekproef vele malen om een betrouwbaar gemiddelde te verkrijgen. Hoewel effectief, is deze methode bijzonder rekenintensief, zeker wanneer duizenden stemrondes moeten worden verwerkt.

Vanaf nu gebruikt LMArena een analytische aanpak op basis van de centrale limietstelling (CLT) in combinatie met M-schatters. Hierdoor kunnen betrouwbaarheidsintervallen direct worden berekend met een gesloten formule, wat het proces aanzienlijk versnelt zonder aan nauwkeurigheid in te boeten. Interne validatie bevestigde dat de resultaten sterk overeenkomen met de oude methode, maar dan met een fractie van de rekentijd.

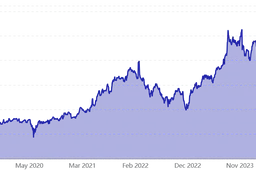

Grafieken tonen nauwkeurigheid en efficiëntie

In de gepubliceerde grafieken op het officiële changelog is te zien dat de nieuwe CLT-gebaseerde intervallen vrijwel gelijk lopen met die van bootstrapping. Dit geldt zowel voor de tekstgebaseerde Arena met stijlcontrole als zonder. De consistentie toont aan dat de versimpelde berekening geen concessies doet aan de kwaliteit.

Eerlijke scoreverdeling met gewogen stemmethodiek

Een andere uitdaging die LMArena aanpakt, is het ongelijke aantal stemmen per model. Nieuwe modellen hebben vaak minder stemmen dan gevestigde namen, wat de representativiteit van scores beïnvloedt. Ook oudere modellen krijgen geen nieuwe stemmen meer zodra ze worden uitgefaseerd.

Om dit te corrigeren, introduceert LMArena een herwegingsmechanisme. Hierbij worden stemresultaten invers gewogen aan de frequentie waarmee modellen in battles verschijnen. Simpel gezegd: hoe minder vaak een model voorkomt, hoe zwaarder de stem weegt. Deze gewogen aanpak zorgt ervoor dat elk model eerlijk wordt meegenomen in het totaalgemiddelde van de ranglijst.

Lees ook

Gevolgen: bredere marges en meer gelijke scores

Een bijkomend effect van de nieuwe aanpak is dat de spreiding in scores toeneemt. Door herweging ontstaat meer statistische variatie, waardoor de betrouwbaarheidsintervallen breder worden. In de praktijk betekent dit dat meer modellen gelijke scores zullen krijgen binnen hun foutmarge, vooral in domeinen met minder stemrondes zoals het vision-onderdeel van de Arena.

Deze verandering benadrukt het streven van LMArena naar eerlijkheid en transparantie in modelvergelijkingen, met als doel een zo representatief mogelijke leaderboard te bieden.

Populair nieuws

Fontys-docent onder vuur om AI-tool die studentgegevens met ChatGPT deelt

AI-assistenten van OpenClaw bouwen hun eigen sociaal netwerk

Oracle-aandelen dalen na plan voor tot 50 miljard dollar AI-financiering

Jensen Huang: Nvidia wil nog steeds investeren in OpenAI

Catharina Ziekenhuis zet AI in om alvleesklierkanker eerder te detecteren

Palantir verrast Wall Street met sterke cijfers dankzij AI en defensie

Laatste reacties

- fascinerend hoe juist bij Martin (die tegen AI in de rechtszaal staat) de verdenking opduikt.. dat ondermijnt vertrouwen op twee fronten.ai_arjanb11-11-2025

- Waarom geen “safety-by-default” met opt-in voor losser gedrag, plus crisis-detectie en directe verwijzing naar hulpdiensten?martijn_aiz30-10-2025

- voor mij werkt AI het best als snelle “co-pilot” voor analyse, maar de eindbeslissing hoort bij mensen.neuraalnicoy30-10-2025

- Sterk stuk! Dit onderstreept waarom “AI bias” en “betrouwbaarheid van AI” cruciaal zijn voor onderwijs en bedrijfslevenkevinkunstmatigh30-10-2025

- Als D66 de verkenner en mogelijk premier levert, dan wordt de toon technocratisch en pragmatischoptimaliserenotto3230-10-2025

- Interessante scenario-analyse een coalitie met D66, VVD, CDA en JA21 klinkt bestuurbaar, maar ik ben benieuwd hoe ze bruggen slaan op thema’s als stikstof, migratie en klimaatbeleidmachineliefhebber6630-10-2025

- Minder finance studeren dus.victorvirtueel6830-08-2025

- Is dit zoals Midjourney of dall-e?deeplearningdames0330-08-2025

- Google is lekker bezigroosrobotice30-08-2025

- Dit is toch wel kwalijk??intelligenteisa5019-06-2025

Loading