Nieuw onderzoek presenteert snelle responsstrategie tegen AI-jailbreaks

Nieuwswoensdag, 13 november 2024 om 22:55

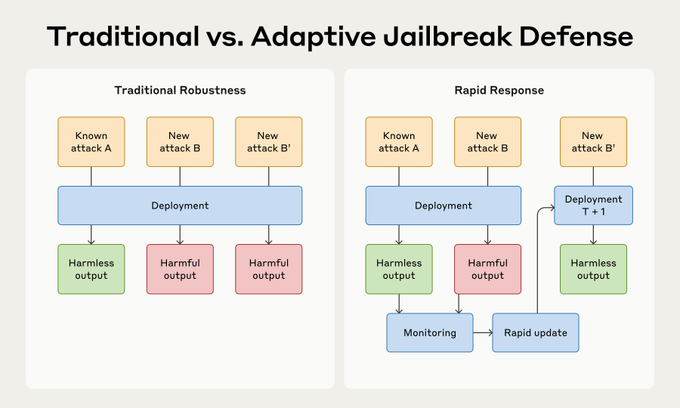

Onderzoekers hebben een nieuwe aanpak ontwikkeld om large language models (LLMs) te beschermen tegen zogeheten jailbreaks, waarbij AI-systemen worden misbruikt voor ongeautoriseerde of schadelijke acties. Het onderzoek richt zich op een snelle respons in plaats van het streven naar onfeilbare beveiliging. De resultaten, gepubliceerd door een team van onderzoekers, tonen aan dat snel reageren op nieuwe aanvalsmethoden een effectieve manier kan zijn om AI-misbruik te beperken.

Snelle respons in plaats van perfecte beveiliging

Het onderzoek introduceert een strategie waarbij in plaats van te streven naar volledige bescherming tegen alle mogelijke aanvallen, wordt gefocust op een "rapid response"-aanpak. Deze aanpak houdt in dat zodra een nieuwe jailbreak wordt gedetecteerd, snel een methode wordt ontwikkeld om deze te blokkeren. De studie benadrukt dat het mogelijk is om hele klassen van jailbreaks te neutraliseren na het observeren van slechts enkele voorbeelden.

De introductie van RapidResponseBench

Om deze benadering te testen, ontwikkelden de onderzoekers een speciaal benchmark-systeem genaamd RapidResponseBench. Dit systeem meet hoe goed een verdedigingsstrategie zich aanpast aan verschillende jailbreaktechnieken na het observeren van een beperkt aantal voorbeelden. De kern van deze methode is jailbreak-proliferatie, waarbij nieuwe jailbreaks automatisch worden gegenereerd op basis van de waargenomen voorbeelden.

Belangrijke resultaten en methoden

Uit de studie bleek dat het fine-tunen van een input-classificator het meest effectief was. Deze classificator blokkeert prolifererende jailbreaks door zich aan te passen aan nieuwe aanvalspatronen. De onderzoekers rapporteerden dat deze methode de succesratio van aanvallen met een factor van meer dan 240 keer verminderde bij in-distributie-aanvallen en met een factor van meer dan 15 keer bij uit-distributie-aanvallen, en dit na slechts één waargenomen voorbeeld van elke aanvalstechniek.

Lees ook

Wie zijn de onderzoekers?

Dit onderzoek is uitgevoerd door een team bestaande uit Alwin Peng, Julian Michael, Henry Sleight, Ethan Perez en Mrinank Sharma. Zij stelden vast dat zowel de kwaliteit van het proliferatiemodel als het aantal gegenereerde voorbeelden cruciaal zijn voor de effectiviteit van deze snelle responsstrategie.

Betekenis voor de toekomst van AI-beveiliging

Naarmate LLM’s, zoals die van OpenAI en andere techbedrijven, steeds geavanceerder worden, neemt ook het risico op misbruik toe. AI-jailbreaks kunnen ertoe leiden dat modellen schadelijke of ongepaste inhoud genereren, wat zowel veiligheids- als ethische problemen kan veroorzaken. Deze nieuwe aanpak biedt een veelbelovende strategie om AI-systemen beter te beschermen zonder afhankelijk te zijn van onfeilbare beveiligingsmaatregelen.

Met deze nieuwe bevindingen zetten de onderzoekers een stap voorwaarts in het verdedigen van AI-systemen tegen misbruik. De snelle responsstrategie kan een cruciale rol spelen in de voortdurende ontwikkeling van veiligere en betrouwbaardere AI-modellen in een steeds complexere digitale wereld.

Populair nieuws

Laatste reacties

- fascinerend hoe juist bij Martin (die tegen AI in de rechtszaal staat) de verdenking opduikt.. dat ondermijnt vertrouwen op twee fronten.ai_arjanb11-11-2025

- Waarom geen “safety-by-default” met opt-in voor losser gedrag, plus crisis-detectie en directe verwijzing naar hulpdiensten?martijn_aiz30-10-2025

- voor mij werkt AI het best als snelle “co-pilot” voor analyse, maar de eindbeslissing hoort bij mensen.neuraalnicoy30-10-2025

- Sterk stuk! Dit onderstreept waarom “AI bias” en “betrouwbaarheid van AI” cruciaal zijn voor onderwijs en bedrijfslevenkevinkunstmatigh30-10-2025

- Als D66 de verkenner en mogelijk premier levert, dan wordt de toon technocratisch en pragmatischoptimaliserenotto3230-10-2025

- Interessante scenario-analyse een coalitie met D66, VVD, CDA en JA21 klinkt bestuurbaar, maar ik ben benieuwd hoe ze bruggen slaan op thema’s als stikstof, migratie en klimaatbeleidmachineliefhebber6630-10-2025

- Minder finance studeren dus.victorvirtueel6830-08-2025

- Is dit zoals Midjourney of dall-e?deeplearningdames0330-08-2025

- Google is lekker bezigroosrobotice30-08-2025

- Dit is toch wel kwalijk??intelligenteisa5019-06-2025

Loading