DeepSeek Review 2025: Kan deze Chinese AI de wereld veranderen?

Reviewswoensdag, 29 januari 2025 om 12:44

AI tools zijn er tegenwoordig in overvloed, en het lijkt alsof er elke maand een nieuwe speler opduikt die belooft sneller, slimmer en goedkoper te zijn dan de rest. DeepSeek V3 is zo’n model dat momenteel veel aandacht trekt vanwege de manier waarop het efficiëntie combineert met geavanceerde technologie. Wat mij nieuwsgierig maakte, is hoe dit model zich staande houdt tussen grote namen als GPT-4 en Claude, en of het echt zo’n slimme keuze is voor wie op zoek is naar een krachtige AI-oplossing zonder de hoofdprijs te betalen.

DeepSeek is gebouwd op Mixture of Experts, wat betekent dat het slechts een fractie van zijn enorme 671 miljard parameters tegelijkertijd activeert. Dit zorgt ervoor dat het model sneller werkt en minder rekenkracht nodig heeft dan sommige concurrenten. In theorie klinkt dat goed, maar de echte vraag is natuurlijk hoe het zich in de praktijk gedraagt. Werkt het soepel? Is het accuraat? En is het de investering waard?

Gebruiksvriendelijkheid

Het eerste wat opvalt, is dat DeepSeek geen kant-en-klare interface biedt zoals sommige andere AI-modellen. Dit betekent dat je als gebruiker net wat meer moeite moet doen om ermee aan de slag te gaan. Toegang krijgen tot de API gaat redelijk vlot, maar het vereist wel dat je zelf integraties opzet of externe tools gebruikt om het model in een praktische workflow te gieten. Voor mensen die al bekend zijn met AI tools is dit geen probleem, maar voor wie hoopt op een gebruiksklare oplossing kan dit een tegenvaller zijn.

Gelukkig is de documentatie goed gestructureerd en zijn er verschillende voorbeelden beschikbaar om je op weg te helpen. Wat ik wel mis, is een laagdrempelige interface waarmee je zonder technische kennis snel een test kunt draaien. Modellen zoals GPT-4 bieden bijvoorbeeld een chatvenster waar je direct een vraag kunt stellen en een antwoord krijgt. DeepSeek vraagt net wat meer voorbereiding voordat je echt kunt beginnen. Dit maakt het aantrekkelijker voor ontwikkelaars en techneuten, maar minder geschikt voor een bredere groep gebruikers.

Lees ook

Functionaliteiten en prestaties

DeepSeek wordt geprezen om zijn prestaties op verschillende benchmarks, vooral op het gebied van wiskunde en programmeren. Dat klinkt indrukwekkend, maar cijfers vertellen niet altijd het hele verhaal. Daarom heb ik het model getest op een reeks praktische taken om te zien hoe het zich houdt in realistische scenario’s.

Eén van de meest opvallende kenmerken is hoe goed DeepSeek code kan analyseren en verbeteren. Tijdens het testen heb ik het model een slordig geschreven Python-script laten opschonen. Het resultaat? Een veel efficiëntere versie van de code, waarbij overbodige elementen waren verwijderd en de structuur overzichtelijker werd. Dit scheelt ontwikkelaars enorm veel tijd en kan helpen om bestaande codebases snel op te schonen. Waar sommige AI-modellen geneigd zijn om extra regels toe te voegen die niet nodig zijn, blijft DeepSeek redelijk dicht bij de originele bedoeling van de gebruiker.

Ook bij het genereren van nieuwe code werkt het verrassend goed. Wanneer ik vroeg om een API-endpoint op te zetten met authenticatie, kreeg ik direct een functioneel stuk code terug. Wat extra fijn was, is dat DeepSeek rekening hield met de beveiligingsaspecten en best practices toepaste zonder dat ik daar expliciet om hoefde te vragen.

Naast coderen is DeepSeek ook getest op zijn vermogen om vragen te beantwoorden over algemene kennis en complexe onderwerpen. Hier deed het model het degelijk, maar het kwam soms net iets minder vloeiend en samenhangend over dan GPT-4. Met name bij diepgaande redeneringen merkte ik dat DeepSeek soms moeite had om lange antwoorden helder te structureren.

Een ander sterk punt is de ondersteuning voor lange contexten. Met een limiet van 128.000 tokens kan DeepSeek grote hoeveelheden tekst verwerken zonder dat de kwaliteit van het antwoord snel afneemt. Dit is ideaal voor mensen die werken met lange documenten of uitgebreide datasets.

Waar het model wat minder goed scoort, is op taken die veel creativiteit vereisen. Vergeleken met GPT-4 voelde DeepSeek minder vloeiend bij het schrijven van langere teksten of het genereren van nieuwe ideeën. Het is duidelijk sterker in analytische taken dan in creatieve toepassingen.

DeepSeek

4.2●

EUR 0.27

DeepSeek V3 is een geavanceerd AI-model met krachtige mogelijkheden op het gebied van codering, wiskunde en meertalige ondersteuning. Het combineert efficiëntie en schaalbaarheid dankzij de innovatieve Mixture of Expertsarchitectuur, waardoor het betaalbaar blijft en uitstekende prestaties levert bij complexe taken zoals API-ontwikkeling, code analyse en lange context verwerking.

…

Meer over dit product

4.5 voor Functionaliteiten

Uitstekende prestaties bij codering en wiskundige benchmarks, maar iets minder krachtig in complexe logica en multimodale taken.

5 voor Prijs-kwaliteitverhouding

Zeer betaalbaar in vergelijking met concurrenten, met lage kosten per miljoen tokens en efficiënte trainingsmethoden.

3.2 voor Gebruiksvriendelijkheid

Lastig te gebruiken omdat hardwarevereisten hoog zijn

Uitstekende contextverwerking tot 128.000 tokens.

Innovatief gebruik van Mixture of Experts (MoE) voor efficiëntie.

Vereist technische kennis voor optimale inzet.

Minder geschikt voor complexe logica of multimodale toepassingen.

Prijs-kwaliteitverhouding

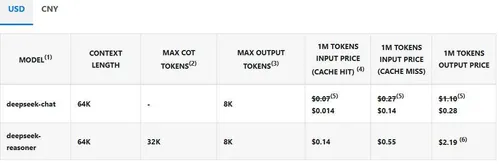

Een van de grootste troeven van DeepSeek is de prijs. Waar het trainen van modellen zoals Llama 3.1 honderden miljoenen kost, is DeepSeek getraind met slechts een fractie van dat budget. Dit vertaalt zich in een relatief lage gebruikskost voor eindgebruikers. De API is aanzienlijk goedkoper dan vergelijkbare diensten, waardoor het een aantrekkelijke optie is voor kleinere bedrijven of individuele ontwikkelaars die een krachtig model willen zonder gigantische kosten.

De prijsstructuur is eenvoudig: gebruikers betalen per miljoen tokens, met verschillende tarieven voor invoer en uitvoer. Dit betekent dat je de kosten goed in de hand kunt houden en niet vastzit aan dure abonnementen. Voor wie regelmatig AI gebruikt in ontwikkelingsprojecten, kan dit een serieuze besparing opleveren.

Toch moet je er rekening mee houden dat DeepSeek vooral interessant is voor mensen die al enige ervaring hebben met AI-integraties. Voor beginners of bedrijven die op zoek zijn naar een direct inzetbare tool kan de technische drempel een nadeel zijn.

Conclusie

DeepSeek V3 is een indrukwekkend AI-model dat uitblinkt in efficiëntie en rekenkracht. Voor wie veel bezig is met programmeren of wiskundige analyses, biedt het een stevige concurrent voor modellen als GPT-4, maar tegen een fractie van de kosten. De manier waarop het code opschoont en API’s genereert, is bijzonder handig voor ontwikkelaars die hun workflow willen versnellen.

Toch is DeepSeek niet voor iedereen de beste keuze. Het model mist een eenvoudige interface en voelt minder soepel aan bij creatieve taken. Mensen die op zoek zijn naar een laagdrempelige AI-chatbot of schrijfhulp, kunnen beter naar andere opties kijken. Maar voor wie efficiëntie en kostenbesparing belangrijker zijn dan gebruiksgemak, is dit zeker een model om in de gaten te houden.

Populair nieuws

Microsoft werkt met Anthropic aan nieuwe generatie AI-assistenten

Deze 3 beroepen kunnen verdwijnen door ChatGPT en AI

Ring probeert privacyzorgen te sussen na Super Bowl-reclame

ClawCon in New York laat de cultuur rond open-source AI zien

Nvidia werkt aan AI-agents die zelfstandig taken van werknemers uitvoeren

X onderzoekt beledigende berichten van AI-chatbot Grok

Laatste reacties

- fascinerend hoe juist bij Martin (die tegen AI in de rechtszaal staat) de verdenking opduikt.. dat ondermijnt vertrouwen op twee fronten.ai_arjanb11-11-2025

- Waarom geen “safety-by-default” met opt-in voor losser gedrag, plus crisis-detectie en directe verwijzing naar hulpdiensten?martijn_aiz30-10-2025

- voor mij werkt AI het best als snelle “co-pilot” voor analyse, maar de eindbeslissing hoort bij mensen.neuraalnicoy30-10-2025

- Sterk stuk! Dit onderstreept waarom “AI bias” en “betrouwbaarheid van AI” cruciaal zijn voor onderwijs en bedrijfslevenkevinkunstmatigh30-10-2025

- Als D66 de verkenner en mogelijk premier levert, dan wordt de toon technocratisch en pragmatischoptimaliserenotto3230-10-2025

- Interessante scenario-analyse een coalitie met D66, VVD, CDA en JA21 klinkt bestuurbaar, maar ik ben benieuwd hoe ze bruggen slaan op thema’s als stikstof, migratie en klimaatbeleidmachineliefhebber6630-10-2025

- Minder finance studeren dus.victorvirtueel6830-08-2025

- Is dit zoals Midjourney of dall-e?deeplearningdames0330-08-2025

- Google is lekker bezigroosrobotice30-08-2025

- Dit is toch wel kwalijk??intelligenteisa5019-06-2025

Loading