Google DeepMind heeft een belangrijke stap gezet in de ontwikkeling van kunstmatige intelligentie. Het bedrijf presenteerde Gemini Robotics 1.5 en Gemini Robotics-ER 1.5, de eerste AI-modellen die robots niet alleen laten handelen, maar ook laten “nadenken” over de beste aanpak van een taak.

Volgens de onderzoekers markeert dit de start van een nieuw tijdperk waarin robots agentische eigenschappen krijgen: ze maken eigen afwegingen voordat ze een handeling uitvoeren.

Van generatieve AI naar generatieve robots

Generatieve AI die tekst, beeld en geluid kan produceren, is inmiddels gemeengoed. DeepMind trekt die lijn nu door naar de fysieke wereld. Waar traditionele robots maanden training nodig hebben voor één enkele taak, zoals het assembleren van onderdelen, belooft de nieuwe aanpak veel breder inzetbare robots. Carolina Parada, hoofd robotica bij Google DeepMind, benadrukt dat generatieve AI cruciaal is: “Robots vandaag zijn hoogst gespecialiseerd en moeilijk inzetbaar. Met Gemini kunnen we juist algemene functionaliteit ontsluiten.”

Hoe werkt Gemini Robotics 1.5?

Het systeem bestaat uit twee afzonderlijke, maar samenwerkende modellen:

- Gemini Robotics-ER 1.5 (Embodied Reasoning): een vision-language model dat instructies en plannen genereert op basis van tekst en visuele input. Dit model kan zelfs externe bronnen zoals Google Search raadplegen om ontbrekende informatie aan te vullen.

- Gemini Robotics 1.5 (Vision-Language-Action): een actiegericht model dat de gegenereerde stappen vertaalt naar concrete robotbewegingen. Het gebruikt camerabeelden om acties nauwkeurig uit te voeren en kan tussentijds reflecteren of een stap slimmer of efficiënter kan.

Een eenvoudig voorbeeld: bij het sorteren van een wasmand met witte en gekleurde kledingstukken bepaalt Gemini-ER eerst de logische stappen. Vervolgens voert Gemini 1.5 deze acties uit met een robotarm, waarbij het model zelf nadenkt hoe het elk kledingstuk het beste kan oppakken.

Leren over verschillende robots heen

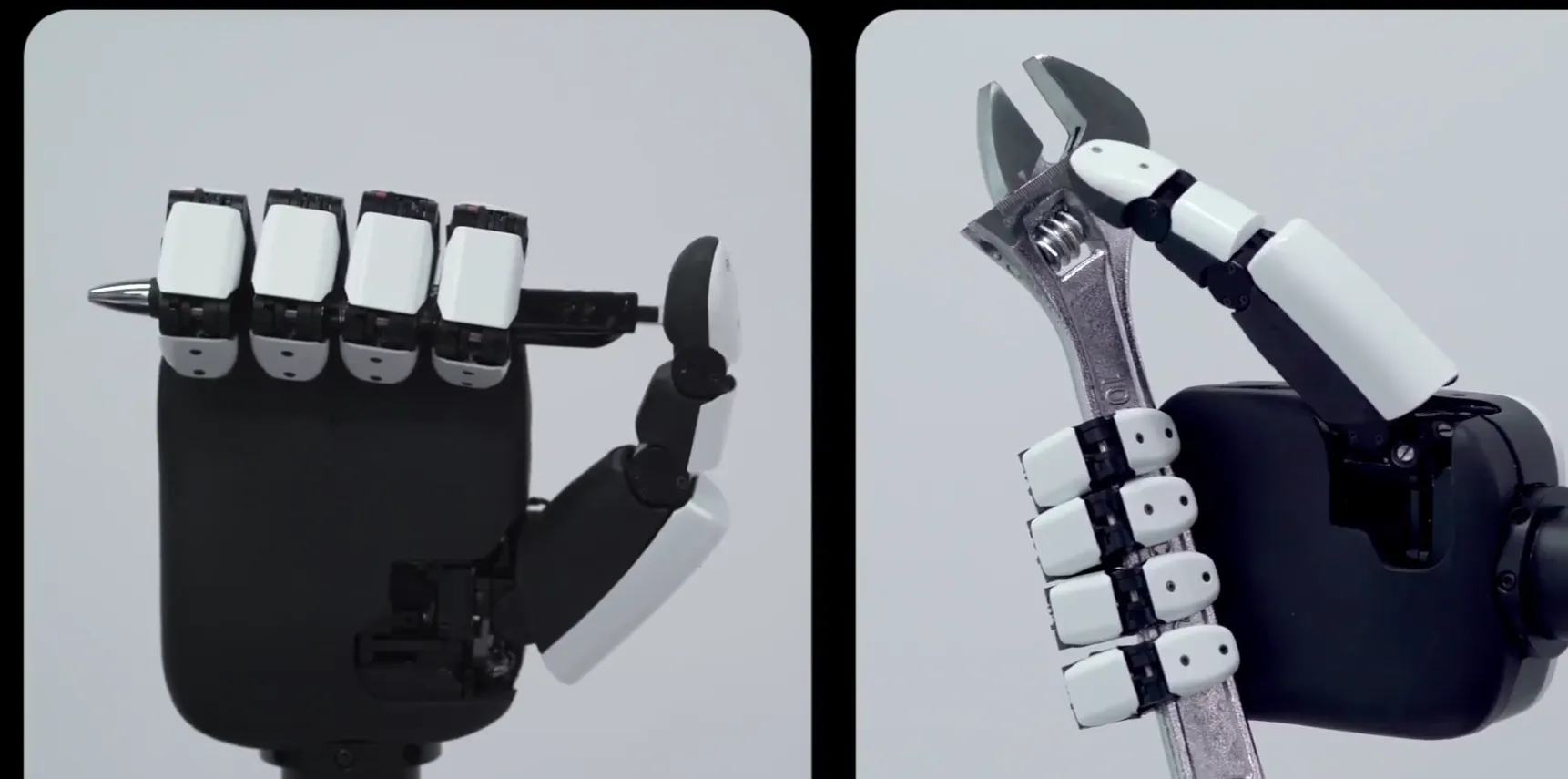

Een opvallend aspect is dat Gemini Robotics 1.5 vaardigheden kan overdragen van het ene robotsysteem naar het andere. Een handeling die is aangeleerd met de grijpers van robot Aloha 2, kan zonder extra training worden toegepast op de mensachtige handen van robot Apollo. Dit bespaart tijd en maakt de technologie schaalbaarder dan eerdere benaderingen.

Nog geen robots in de huiskamer

Hoewel de vooruitgang indrukwekkend is, blijft praktische toepassing voorlopig beperkt. Het actie-model Gemini Robotics 1.5 wordt uitsluitend getest door geselecteerde partners. Het denksysteem Gemini-ER 1.5 komt wel beschikbaar in Google AI Studio, zodat ontwikkelaars experimenten kunnen uitvoeren met fysieke robots en eigen instructies.

DeepMind-onderzoeker Kanishka Rao legt de kern uit: “Mensen gebruiken intuïtieve gedachten om taken te sturen. Robots hadden dit niet. Met Gemini 1.5 hebben we robots een eerste vorm van intuïtie gegeven, zodat ze leren denken voor ze handelen.”

Lees ook

Een blik vooruit

Met de lancering van Gemini Robotics 1.5 zet DeepMind een grote stap richting zelfstandige, breed inzetbare robots. Toch blijft het voorlopig bij gecontroleerde experimenten. De vraag is niet óf, maar wanneer consumentenrobots met deze technologie hun intrede doen in huishoudens en fabrieken.

Populair nieuws

Indeed waarschuwt: Nederland blijft structureel achter in AI-adoptie

iPhone 17e lijkt binnenkort te verschijnen met A19-chip en MagSafe

Eerste tekenen van burn-out bij mensen die AI het meest omarmen

Cloudera rolt AI-inferentie en analyses uit voor on-premises datacenters

Cisco introduceert Silicon One G300-chip voor energiezuinige AI-datacenters

Macron reist naar India voor top over kunstmatige intelligentie

Laatste reacties

- fascinerend hoe juist bij Martin (die tegen AI in de rechtszaal staat) de verdenking opduikt.. dat ondermijnt vertrouwen op twee fronten.ai_arjanb11-11-2025

- Waarom geen “safety-by-default” met opt-in voor losser gedrag, plus crisis-detectie en directe verwijzing naar hulpdiensten?martijn_aiz30-10-2025

- voor mij werkt AI het best als snelle “co-pilot” voor analyse, maar de eindbeslissing hoort bij mensen.neuraalnicoy30-10-2025

- Sterk stuk! Dit onderstreept waarom “AI bias” en “betrouwbaarheid van AI” cruciaal zijn voor onderwijs en bedrijfslevenkevinkunstmatigh30-10-2025

- Als D66 de verkenner en mogelijk premier levert, dan wordt de toon technocratisch en pragmatischoptimaliserenotto3230-10-2025

- Interessante scenario-analyse een coalitie met D66, VVD, CDA en JA21 klinkt bestuurbaar, maar ik ben benieuwd hoe ze bruggen slaan op thema’s als stikstof, migratie en klimaatbeleidmachineliefhebber6630-10-2025

- Minder finance studeren dus.victorvirtueel6830-08-2025

- Is dit zoals Midjourney of dall-e?deeplearningdames0330-08-2025

- Google is lekker bezigroosrobotice30-08-2025

- Dit is toch wel kwalijk??intelligenteisa5019-06-2025

Loading