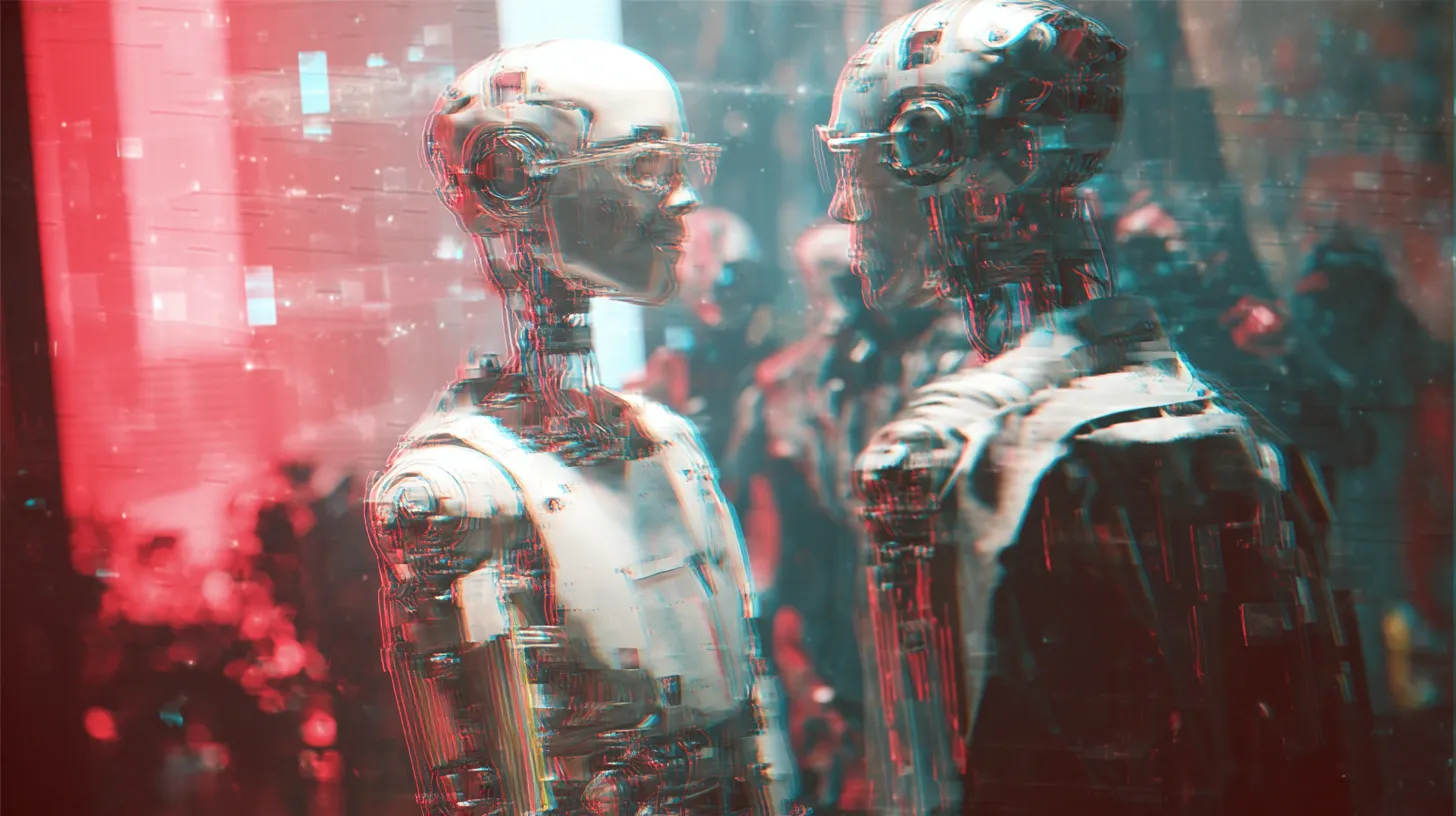

OpenAI werkt samen met Bryan Cranston en acteerbond SAG-AFTRA aan scherpere regels voor deepfakes

Nieuwswoensdag, 22 oktober 2025 om 17:00

Acteur Bryan Cranston, bekend van onder andere Breaking Bad, en de acteerbond SAG‑AFTRA hebben samen met OpenAI een verklaring uitgebracht na ongeautoriseerde video’s waarin Cranston’s gezicht en stem werden gebruikt op het videogenererende platform Sora 2. In één video was hij zelfs te zien in een selfie met Michael Jackson. OpenAI heeft daarop zijn beleid aangepast: voortaan moeten personen expliciet instemmen (“opt-in”) voordat hun gelijkenis of stem gebruikt mag worden, aldus Business Insider.

Waarom is dit belangrijk?

Deepfakes, video’s of audio waarin echt lijkende personen dingen doen of zeggen die ze nooit gedaan hebben, worden steeds realistischer en makkelijker te maken. Daarmee ontstaat het risico dat iemands reputatie, privacy of carrière wordt aangetast. OpenAI zegt dat deze stap nodig is om makers, acteurs en publieke figuren te beschermen tegen onoordeelkundige regeneratie van hun identiteit. Volgens SAG-AFTRA-voorzitter Sean Astin zou wetgeving zoals de voorgestelde “NO FAKES Act” in de VS vereist zijn om misbruik juridisch aan te pakken.

Wat gaat OpenAI veranderen?

In de gezamenlijke verklaring hebben OpenAI en de betrokken partijen aangegeven dat mensen in de toekomst zelf moeten kunnen kiezen of hun stem en gelijkenis gebruikt mogen worden. OpenAI zegt “nabestaanden, artiesten en individuen moeten controle hebben over hoe en of zij gesimuleerd worden”. Verder belooft het bedrijf klachten over ongeautoriseerde beelden voortaan “expeditiously” te behandelen.

Er wordt echter geen exact tijdspad genoemd of gedetailleerde technische maatregelen vrijgegeven. De verandering is nog in ontwikkeling en er blijft aandacht voor hoe effectief de nieuwe regels zullen zijn.

Waar zitten de zorgen nog?

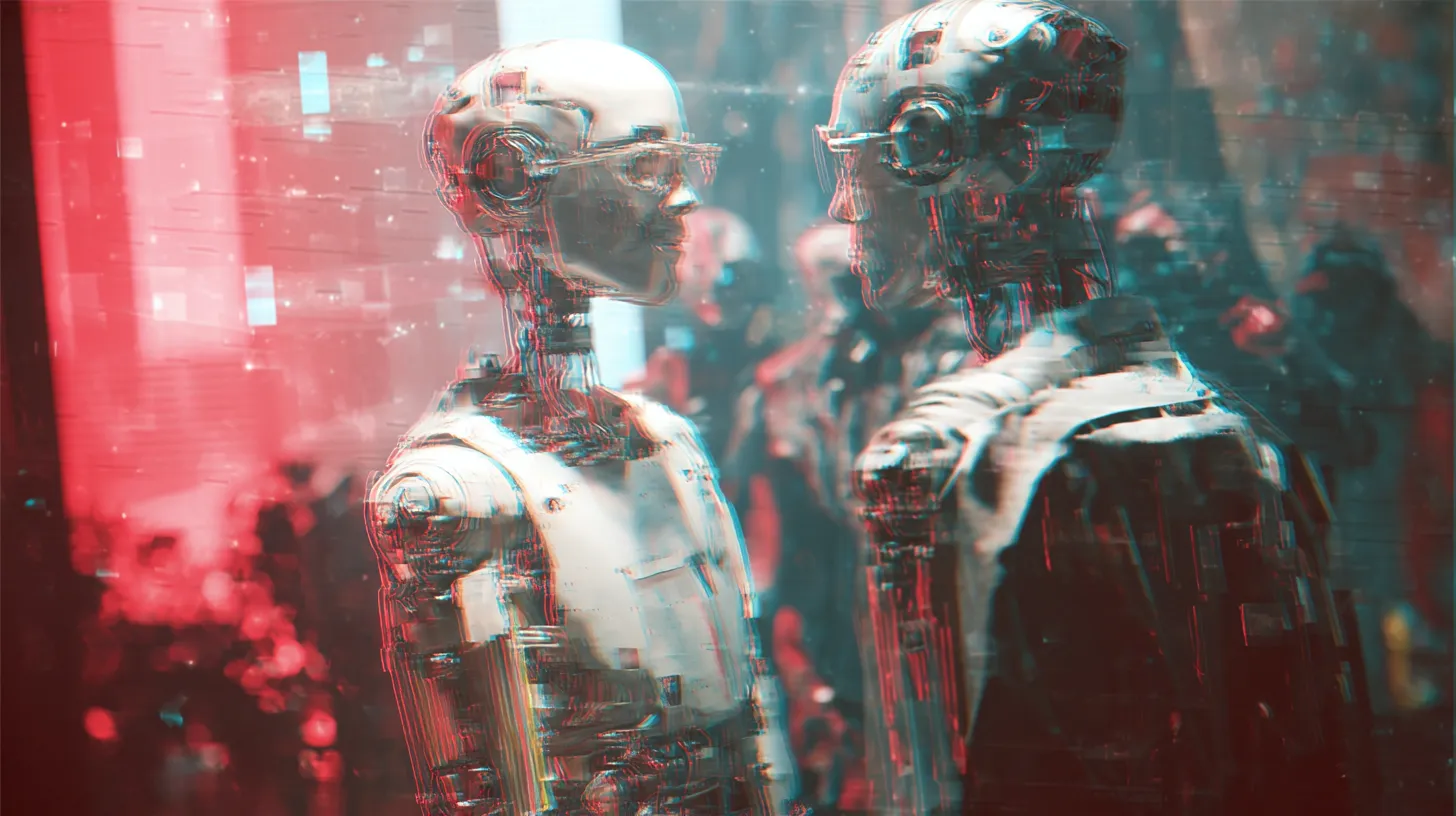

Hoewel deze stap door veel makers wordt begroet, blijven er open vragen. Het systeem lijkt voorlopig gericht op levende publieke figuren, terwijl nabestaanden van overleden personen regelmatig ook slachtoffer zijn van deepfakes. Daarnaast blijft toezicht nodig: een “opt-in”-beleid klinkt goed, maar in de praktijk moet gecontroleerd worden of de opt-in daadwerkelijk verifieerbaar is, of misbruik toch plaatsvindt, en hoe consequent verwijderd wordt wanneer dat nodig is.

Wat betekent het voor de toekomst?

De samenwerking tussen Cranston, SAG-AFTRA en OpenAI markeert een belangrijk moment waarin de entertainmentindustrie duidelijker laat zien dat creatieve makers niet willen dat hun identiteit door AI-tools wordt misbruikt. Of de aangepaste regels voldoende zijn om massale deepfake-productie te voorkomen, zal de komende maanden blijken.

Het is een stap naar meer verantwoordelijkheid van techbedrijven: niet alleen in het leveren van geavanceerde AItechnologie, maar ook in het beschermen van mensen en hun rechten. Met deze ontwikkeling groeit het besef dat niet alleen technische maar ook ethische en juridische strategieën nodig zijn in de AI-wereld.

Lees ook

doorMaartje

Populair nieuws

Dit zegt ChatGPT over de stijgende olie- én gasprijs

ChatGPT over nieuwe Ajax-coach Óscar García: dit zegt de AI over zijn kansen

Amsterdamse startup bouwt AI-collega’s die bedrijfsprocessen overnemen

Microsoft werkt met Anthropic aan nieuwe generatie AI-assistenten

Ring probeert privacyzorgen te sussen na Super Bowl-reclame

Bedrijven willen AI, maar hun data is er nog niet klaar voor

Laatste reacties

- fascinerend hoe juist bij Martin (die tegen AI in de rechtszaal staat) de verdenking opduikt.. dat ondermijnt vertrouwen op twee fronten.ai_arjanb11-11-2025

- Waarom geen “safety-by-default” met opt-in voor losser gedrag, plus crisis-detectie en directe verwijzing naar hulpdiensten?martijn_aiz30-10-2025

- voor mij werkt AI het best als snelle “co-pilot” voor analyse, maar de eindbeslissing hoort bij mensen.neuraalnicoy30-10-2025

- Sterk stuk! Dit onderstreept waarom “AI bias” en “betrouwbaarheid van AI” cruciaal zijn voor onderwijs en bedrijfslevenkevinkunstmatigh30-10-2025

- Als D66 de verkenner en mogelijk premier levert, dan wordt de toon technocratisch en pragmatischoptimaliserenotto3230-10-2025

- Interessante scenario-analyse een coalitie met D66, VVD, CDA en JA21 klinkt bestuurbaar, maar ik ben benieuwd hoe ze bruggen slaan op thema’s als stikstof, migratie en klimaatbeleidmachineliefhebber6630-10-2025

- Minder finance studeren dus.victorvirtueel6830-08-2025

- Is dit zoals Midjourney of dall-e?deeplearningdames0330-08-2025

- Google is lekker bezigroosrobotice30-08-2025

- Dit is toch wel kwalijk??intelligenteisa5019-06-2025

Loading