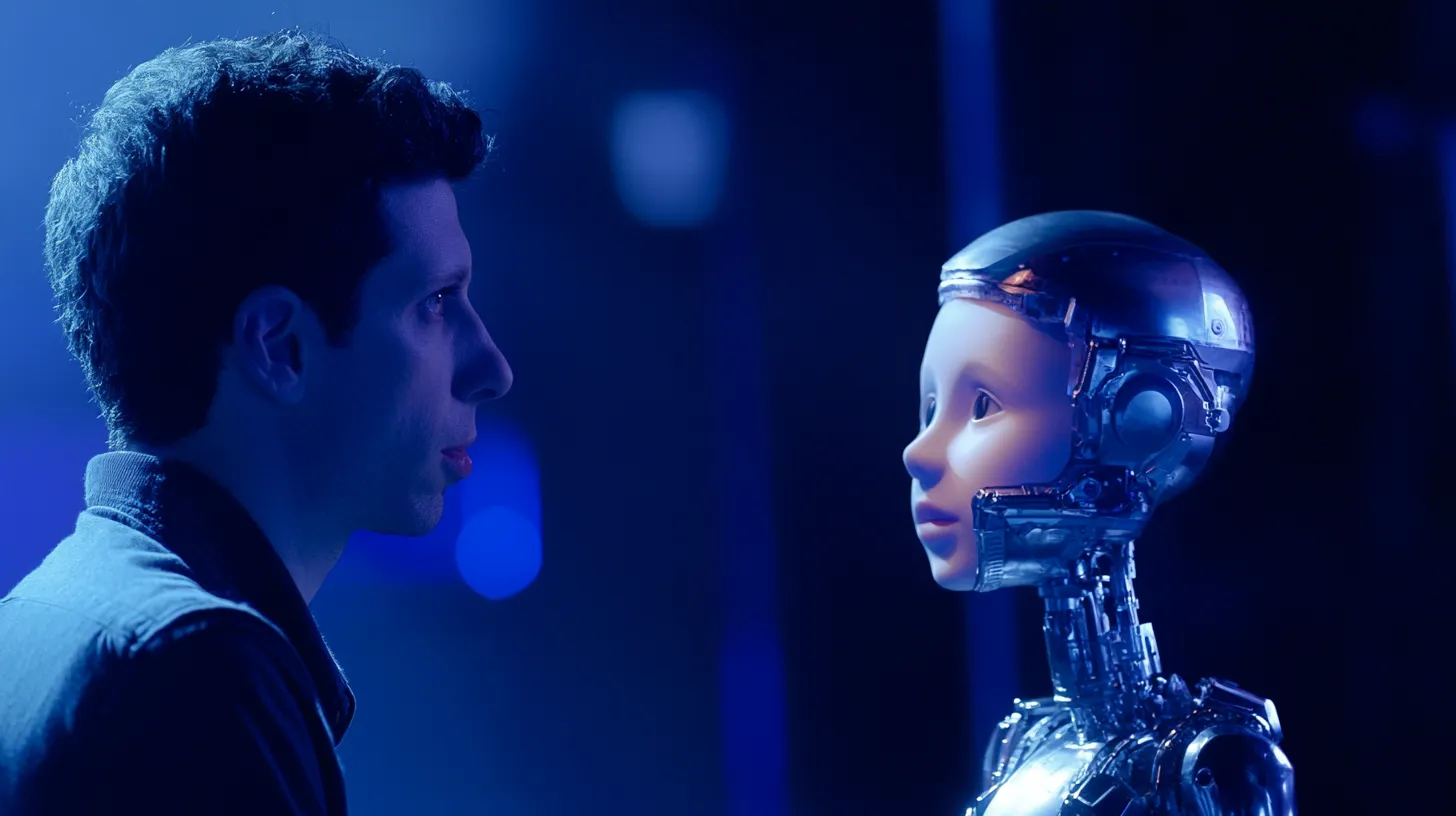

Nieuwe onderzoeksmethoden voor OpenAI om slimmere AI te ontwikkelen

Nieuwsdinsdag, 12 november 2024 om 10:00

In de wereld van AI hebben grote bedrijven zoals OpenAI en andere AI-ondernemingen te maken met een belangrijk probleem, de traditionele aanpak voor het verbeteren van taalmodellen levert niet langer de gewenste resultaten op. Het vergroten van taalmodellen door simpelweg meer data en rekenkracht toe te voegen blijkt zijn effectiviteit te verliezen. Hierdoor is er dringend behoefte aan nieuwe trainingsmethoden om slimmere kunstmatige intelligentie te kunnen bouwen.

Ilya Sutskever, mede-oprichter van OpenAI, benadrukt dat de traditionele strategie van "bigger is better" (groter is beter) zijn effect heeft verloren. Het opschalen van AI training door het gebruik van steeds grotere hoeveelheden ongestructureerde data heeft geleid tot afvlakkende prestaties. In plaats van te blijven investeren in meer data, is het tijd voor nieuwe benaderingen die verder gaan dan enkel omvang.

Uitdagingen AI ontwikkeling

Een van de uitdagingen bij het trainen van grote taalmodellen is de enorme hoeveelheid data en energie die nodig is. Dit zorgt niet alleen voor vertragingen in het ontwikkelingsproces, maar verhoogt ook de kosten. Het trainen van deze modellen vereist geavanceerde hardware die vaak complex is en gevoelig voor storingen, wat leidt tot nog meer vertragingen.

Om deze problemen het hoofd te bieden, onderzoeken onderzoekers nieuwe technieken zoals "test-time compute". Bij deze methode genereert het AI model meerdere mogelijkheden tijdens de “inference-fase” (de fase waarin het model beslissingen maakt), waarna het real-time evalueert welke optie het beste is. Dit zou kunnen helpen om betere en snellere besluitvorming mogelijk te maken.

Nieuw O1 model van OpenAI

Een andere interessante ontwikkeling is het nieuwe model "O1" van OpenAI. Dit model maakt gebruik van meerdere stappen om problemen op te lossen, vergelijkbaar met menselijke redenering. O1 is getraind op de basisversie van GPT-4, maar bevat ook extra data van experts en PhD’s, waardoor het in staat is om complexere vraagstukken aan te pakken.

Lees ook

Populair nieuws

EU opent Frontier AI Grand Challenge om Europees topmodel van 400 miljard parameters te trainen

Bedrijf achter TikTok past de beveiliging van AI-videogenerator Seedance aan na kritiek

Airbnb onthult AI klantenservice die al 33 procent van vragen oplost

Ierland start officieel onderzoek naar Grok AI van Elon Musk

Cohere met $240M jaarlijkse omzet zet koers naar mogelijke beursgang in 2026

AI-datacenters slokken harde schijven op in 2026

Laatste reacties

- fascinerend hoe juist bij Martin (die tegen AI in de rechtszaal staat) de verdenking opduikt.. dat ondermijnt vertrouwen op twee fronten.ai_arjanb11-11-2025

- Waarom geen “safety-by-default” met opt-in voor losser gedrag, plus crisis-detectie en directe verwijzing naar hulpdiensten?martijn_aiz30-10-2025

- voor mij werkt AI het best als snelle “co-pilot” voor analyse, maar de eindbeslissing hoort bij mensen.neuraalnicoy30-10-2025

- Sterk stuk! Dit onderstreept waarom “AI bias” en “betrouwbaarheid van AI” cruciaal zijn voor onderwijs en bedrijfslevenkevinkunstmatigh30-10-2025

- Als D66 de verkenner en mogelijk premier levert, dan wordt de toon technocratisch en pragmatischoptimaliserenotto3230-10-2025

- Interessante scenario-analyse een coalitie met D66, VVD, CDA en JA21 klinkt bestuurbaar, maar ik ben benieuwd hoe ze bruggen slaan op thema’s als stikstof, migratie en klimaatbeleidmachineliefhebber6630-10-2025

- Minder finance studeren dus.victorvirtueel6830-08-2025

- Is dit zoals Midjourney of dall-e?deeplearningdames0330-08-2025

- Google is lekker bezigroosrobotice30-08-2025

- Dit is toch wel kwalijk??intelligenteisa5019-06-2025

Loading