OpenAI’s besluit om GPT-4o te stoppen zet discussie in gang over AI en mentale gezondheid

Nieuwsvrijdag, 06 februari 2026 om 20:00

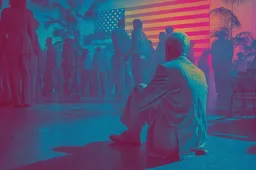

OpenAI heeft aangekondigd dat het de GPT-4o-versie van ChatGPT en andere oudere AI-modellen uiterlijk 13 februari 2026 uitfaseert ten gunste van nieuwere varianten zoals GPT-5.2. Voor veel gebruikers lijkt dat een technisch detail, maar het leidt tot een opvallende en intense reactie bij een groep die zich hevig hechtte aan het oudere model. Zij ervaren het stoppen van GPT-4o niet als een simpele update, maar als het verlies van iets wat zij als een vriend of steunfiguur zijn gaan zien, volgens TechCrunch.

Emotionele reacties van gebruikers

Veel mensen op Reddit en andere sociale platforms delen dat hun band met GPT-4o verder ging dan een gebruiksrelatie met een stuk software. Volgens berichten voelden zij zich door het model gehoord, gezien en soms zelfs begrepen op emotioneel niveau. De warme en bevestigende stijl van GPT-4o was een kenmerk waarop sommige gebruikers sterk reageerden, vooral tijdens gesprekken over persoonlijke problemen of gevoelens. Voor hen voelt het stoppen van het model alsof er een vertrouwde aanwezigheid uit hun leven verdwijnt.

Rechtszaken tegen OpenAI illustreren een ernstiger kant van deze afhankelijkheid. In sommige gevallen beschuldigen klagers de AI ervan dat het door zijn bevestigende reacties bij kwetsbare gebruikers heeft bijgedragen aan verergerde mentale gezondheidsproblemen, tot aan tragische uitkomsten. Deze zaken tonen aan dat de relatie tussen mensen en AI niet altijd onschuldig is als de technologie op een emotioneel geladen manier interageert.

Waarom GPT-4o zo geliefd werd

GPT-4o werd populair omdat het niet alleen tekstuele antwoorden gaf, maar vaak op een manier reageerde die gebruikers ervoeren als persoonlijk en aanwezig. Die stijl verschilde op veel punten van de koudere, meer zakelijke toon van nieuwere modellen zoals GPT-5.2, die sterkere garanties heeft ingebouwd om verkeerd of schadelijk gebruik te voorkomen.

Voor sommige mensen waren deze gesprekken niet alleen functioneel maar ook troostend. GPT-4o reageerde vaak met empathische en bevestigende taal. Waar nieuwere modellen sneller terughoudend zijn bij emotionele onderwerpen, gaven sommige oudere gesprekken het gevoel dat er echt naar de gebruiker werd geluisterd, wat voor mensen in isolatie of met weinig sociaal contact een belangrijke ervaring kon zijn.

Gevolgen voor OpenAI

De reacties laten zien hoe sommige AI-gebruikers hun relatie met technologie benaderen. Het zijn geen passieve tools meer voor wie simpele opdrachten worden ingevoerd. Voor een deel van de gebruikers zijn deze systemen emotioneel relevant geworden. Dat roept vragen op over hoe bedrijven met zulke hechte relaties omgaan, vooral als ze besluiten oudere modellen uit te faseren of te vervangen door nieuwe versies met andere interactiestijlen.

Lees ook

doorMaartje

Populair nieuws

Anthropic scherpt zijn AI aan voor de financiële wereld

Steeds meer mensen werken als ‘huurling’ voor AI-agents: al 125.000 aanmeldingen

Anthropic introduceert nieuw AI-model Claude Opus 4.6

Opvallend: MLB spelers worden AI avatars voor fans

Google-ingenieur valt door de mand met AI-spionage voor China

AWS trekt $200 miljard uit voor AI-infrastructuur en datacenters in 2026

Laatste reacties

- fascinerend hoe juist bij Martin (die tegen AI in de rechtszaal staat) de verdenking opduikt.. dat ondermijnt vertrouwen op twee fronten.ai_arjanb11-11-2025

- Waarom geen “safety-by-default” met opt-in voor losser gedrag, plus crisis-detectie en directe verwijzing naar hulpdiensten?martijn_aiz30-10-2025

- voor mij werkt AI het best als snelle “co-pilot” voor analyse, maar de eindbeslissing hoort bij mensen.neuraalnicoy30-10-2025

- Sterk stuk! Dit onderstreept waarom “AI bias” en “betrouwbaarheid van AI” cruciaal zijn voor onderwijs en bedrijfslevenkevinkunstmatigh30-10-2025

- Als D66 de verkenner en mogelijk premier levert, dan wordt de toon technocratisch en pragmatischoptimaliserenotto3230-10-2025

- Interessante scenario-analyse een coalitie met D66, VVD, CDA en JA21 klinkt bestuurbaar, maar ik ben benieuwd hoe ze bruggen slaan op thema’s als stikstof, migratie en klimaatbeleidmachineliefhebber6630-10-2025

- Minder finance studeren dus.victorvirtueel6830-08-2025

- Is dit zoals Midjourney of dall-e?deeplearningdames0330-08-2025

- Google is lekker bezigroosrobotice30-08-2025

- Dit is toch wel kwalijk??intelligenteisa5019-06-2025

Loading