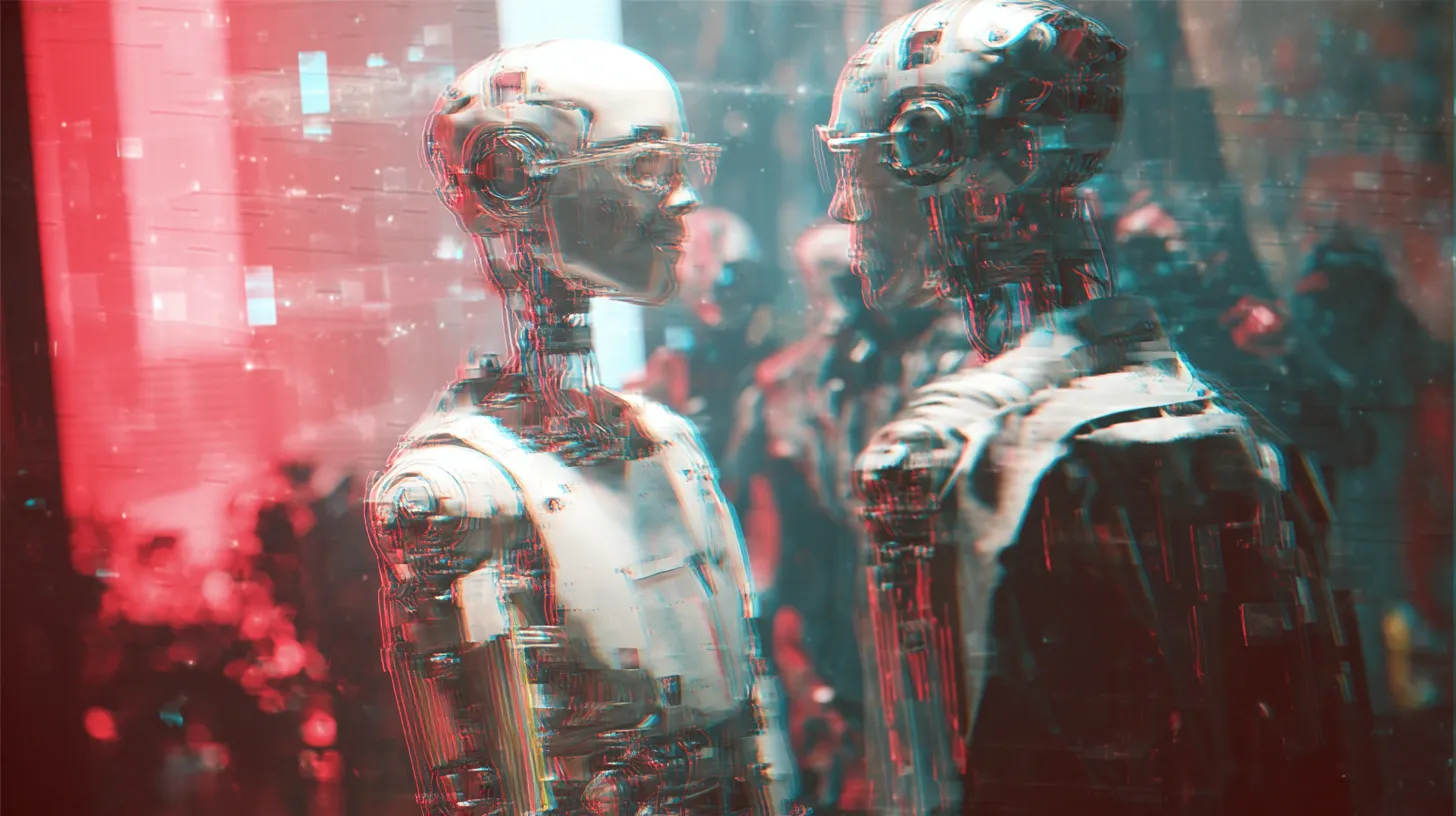

Na berichten over de ontvoering en arrestatie van de Venezolaanse president Nicolás Maduro door Amerikaanse troepen verspreidden zich online talloze beelden die ogenschijnlijk deze gebeurtenissen toonden. Veel van die afbeeldingen en video’s bleken echter niet authentiek, maar gemaakt met generatieve kunstmatige intelligentie en moeilijk van echte foto’s of beelden te onderscheiden. Dit illustreert de groeiende kracht van AI-tools om visuele content te produceren die mensen snel kunnen verwarren of als echt beschouwen, ook zonder duidelijke aanwijzingen dat het om nep gaat, volgens Nu.nl.

Verspreiding van gemanipuleerde beelden

Op sociale media verschenen na het nieuws over Maduro beelden die hem in handboeien lieten zien, omringd door gewapende mannen of in andere dramatische contexten. Analyses van verschillende fact-checkorganisaties toonden aan dat deze afbeeldingen en bijbehorende video’s waren gemaakt met behulp van AI tools en geen verband hadden met echte foto’s die door nieuwsagentschappen waren vrijgegeven. In sommige gevallen werd software gebruikt om de beelden te genereren en watermerken of andere aanwijzingen die normaal de herkomst tonen, waren verwijderd of verborgen.

De nepbeelden verspreidden zich snel omdat mensen op zoek waren naar visuele bevestiging van wat er gebeurd zou zijn. In de vroege uren na berichten over Maduro’s arrestatie plaatsten gebruikers de beelden op platforms zoals X, Facebook en TikTok voordat officiële foto’s beschikbaar waren. Daardoor kregen de AI-creaties meer zichtbaarheid dan echte beelden van de situatie.

Denkfouten en technische signalen

De gemanipuleerde visuals bevatten vaak subtiele fouten die wijzen op hun kunstmatige oorsprong. Zo kunnen de verhoudingen van lichamen, kledingdetails of achtergrondobjecten inconsistent zijn, of zijn er opvallende afwijkingen in licht en schaduw. Detectietools die specifiek zijn ontworpen om AI-gegenereerde content te herkennen, zoals SynthID van Google, gaven in meerdere gevallen aan met een hoge mate van zekerheid dat de beelden synthetisch waren.

Toch zijn deze technische signalen voor veel mensen moeilijk zelf te herkennen. Voor de gemiddelde gebruiker lijken de beelden realistisch genoeg om waar te kunnen zijn, zeker als zij zichzelf verspreiden binnen de context van actualiteit of urgent nieuws.

De rol van sociale media

Sociale netwerken speelden een grote rol in de verspreiding van de beelden. Platforms die content automatisch aanbevelen of die viraal gaan op basis van engagement kunnen onbedoeld bijdragen aan de snelle verspreiding van misleidende AI-beelden. Wanneer duizenden of honderdduizenden gebruikers een afbeelding delen, onderschrijven zij indirect de indruk dat de beelden authentiek zijn, ook al zijn de bronnen dubieus.

Deze dynamiek maakt het lastiger om de grens tussen echte en neppe content te zien, vooral in periodes van snel veranderend nieuws. Gebruikers herkennen dit vaak pas nadat onafhankelijke fact-checkers de beelden hebben geanalyseerd en ontkracht.

Lees ook

doorMaartje

Populair nieuws

Dit zegt ChatGPT over de stijgende olie- én gasprijs

Amsterdamse startup bouwt AI-collega’s die bedrijfsprocessen overnemen

Microsoft werkt met Anthropic aan nieuwe generatie AI-assistenten

Ring probeert privacyzorgen te sussen na Super Bowl-reclame

ClawCon in New York laat de cultuur rond open-source AI zien

Bedrijven willen AI, maar hun data is er nog niet klaar voor

Laatste reacties

- fascinerend hoe juist bij Martin (die tegen AI in de rechtszaal staat) de verdenking opduikt.. dat ondermijnt vertrouwen op twee fronten.ai_arjanb11-11-2025

- Waarom geen “safety-by-default” met opt-in voor losser gedrag, plus crisis-detectie en directe verwijzing naar hulpdiensten?martijn_aiz30-10-2025

- voor mij werkt AI het best als snelle “co-pilot” voor analyse, maar de eindbeslissing hoort bij mensen.neuraalnicoy30-10-2025

- Sterk stuk! Dit onderstreept waarom “AI bias” en “betrouwbaarheid van AI” cruciaal zijn voor onderwijs en bedrijfslevenkevinkunstmatigh30-10-2025

- Als D66 de verkenner en mogelijk premier levert, dan wordt de toon technocratisch en pragmatischoptimaliserenotto3230-10-2025

- Interessante scenario-analyse een coalitie met D66, VVD, CDA en JA21 klinkt bestuurbaar, maar ik ben benieuwd hoe ze bruggen slaan op thema’s als stikstof, migratie en klimaatbeleidmachineliefhebber6630-10-2025

- Minder finance studeren dus.victorvirtueel6830-08-2025

- Is dit zoals Midjourney of dall-e?deeplearningdames0330-08-2025

- Google is lekker bezigroosrobotice30-08-2025

- Dit is toch wel kwalijk??intelligenteisa5019-06-2025

Loading