Kwetsbare tieners op Instagram zien vaker content over eetstoornissen

Nieuwsdinsdag, 21 oktober 2025 om 15:00

Een intern onderzoek van Meta heeft aangetoond dat tieners die aangeven vaak negatief over hun lichaam te denken, aanzienlijk vaker voor risicocontent worden geplaatst op Instagram dan hun leeftijdsgenoten. Bij de groep tieners die drie of meer dagen per week meldde zich slecht te voelen over hun lichaam, maakte zogenoemde “eating-disorder-adjacent” content 10,5% uit van de gepresenteerde feed. Bij de andere groep was dat slechts 3,3%, volgens Reuters.

Die content omvat berichten waarin lichaamsdelen prominent worden getoond, expliciete oordelen over lichaamstypes voorkomen, of waarin verwijzingen staan naar eetstoornissen en een negatief lichaamsbeeld.

Niet alleen eetstoornis-content

Het onderzoek van Meta vond ook dat diezelfde groep tieners vaker andere “risicocontent” te zien kreeg. Ongeveer 27 % van hun feed bestond uit berichten met mature thema’s, gevaarlijk gedrag, schadelijke inhoud of lijden. Ter vergelijking: bij hun leeftijdsgenoten was dat aandeel 13,6%.

Hoewel het onderzoek geen direct causaal verband laat zien, dus niet vaststaat dat de feed de negatieve zelfbeleving veroorzaakt, wordt wel duidelijk dat er een sterke correlatie is. De onderzoekers schrijven expliciet dat het niet mogelijk is om te bepalen of gebruikers met een negatief lichaamsgevoel actief op zoek zijn naar dit soort content, of erdoor geraakt worden.

Meta erkent beperkingen

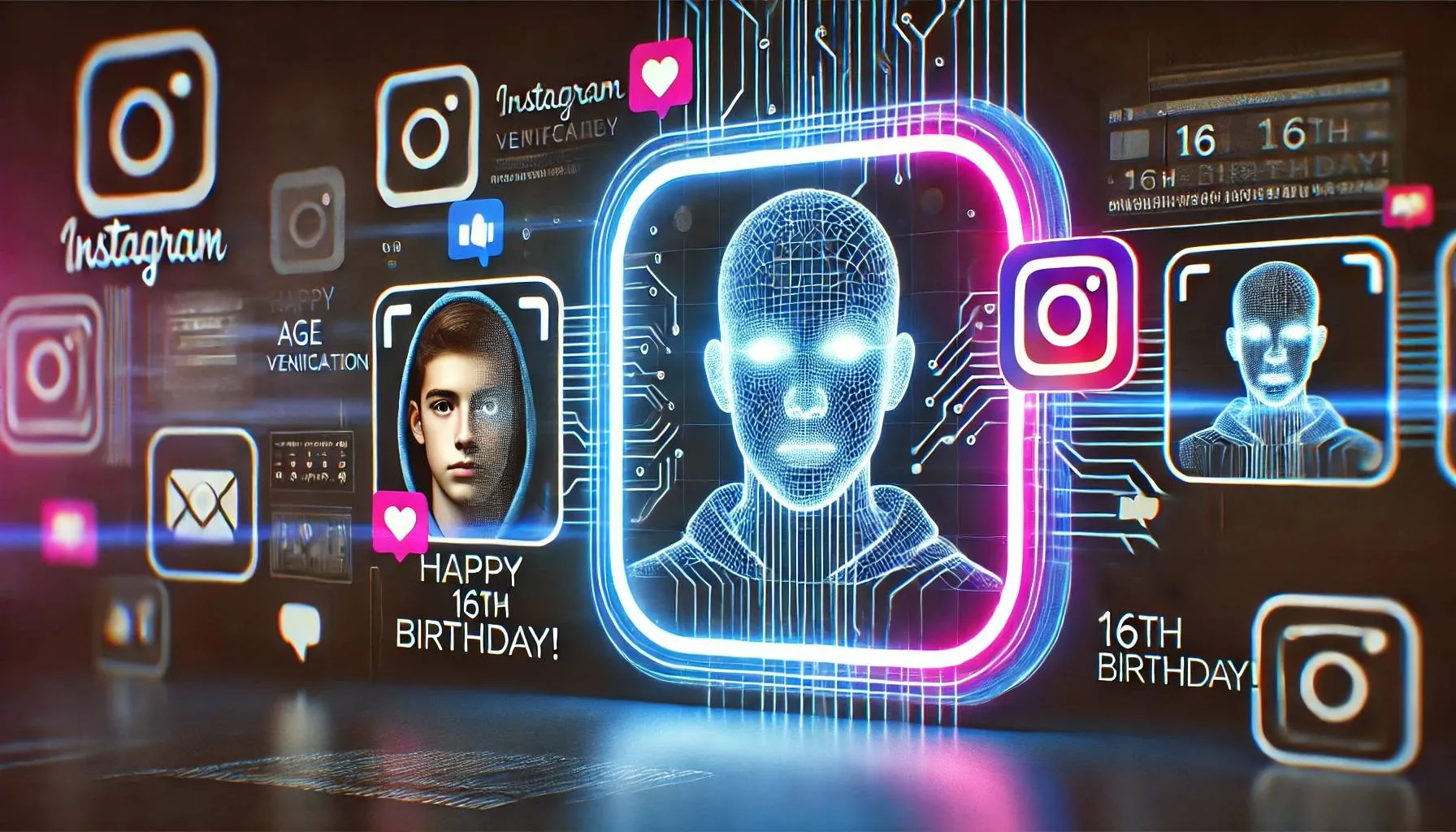

Meta zegt dat haar huidige algoritmes tot dusver slechts 1,5 % van de “gevoelige” content konden detecteren die volgens het onderzoeksrapport mogelijk niet geschikt is voor tieners. Het bedrijf benadrukt te werken aan verbetering en verwees naar recente stappen om onder-18-accounts standaard in te stellen op meer restrictieve instellingen.

Een woordvoerder stelde dat het onderzoek aantoont hoe serieus Meta kijkt naar de ervaring van jonge gebruikers en zegt dat het platform “veiligere en ondersteunende” plekken wil zijn voor tieners.

Waarom dit belangrijk is

De bevindingen zijn significant omdat ze een patroon aangeven van kwetsbare tieners die meer risicovolle content te zien krijgen, in een omgeving die ze juist zou moeten beschermen. Door de combinatie van sociaal-mediaonderzoek, intern document en data uit de praktijk ontstaat er steeds meer aandacht voor de mogelijke schadelijke effecten van algoritmes op jonge gebruikers.

Voor ouders, scholen en beleidsmakers is dit een waarschuwing: de feed van sociale media is geen neutraal overlijkscherm en algoritmes kunnen onbedoeld bijdragen aan vijandige of verontrustende beelden bij jongeren die al gevoelig zijn.

Wat nu?

Meta staat onder toenemende maatschappelijke en juridische druk. Rechters, wetgevers en experts onderzoeken of sociale-media-bedrijven voldoende doen om kwetsbaren te beschermen. Het interne onderzoek brengt nieuwe inzichten, maar hoeveel daarvan daadwerkelijk leidt tot verankerde verandering, is nog onduidelijk.

Speciaal voor gebruik door tieners zou de vraag kunnen zijn: hoe worden algoritmes aangepast? Wordt content die risico’s loopt eerder verwijderd of geclassificeerd? En worden ouders of verzorgers adequaat geïnformeerd over de risico’s van dergelijke feeds? Hoewel het onderzoek geen bewijst dat Instagram deze content actief promoot, laat het wél zien dat het systeem van aanbevelingen voor sommige gebruikers mogelijk fungeert als versterker van kwetsbaarheid.

Lees ook

doorMaartje

Populair nieuws

Dit zegt ChatGPT over de stijgende olie- én gasprijs

ChatGPT over nieuwe Ajax-coach Óscar García: dit zegt de AI over zijn kansen

Amsterdamse startup bouwt AI-collega’s die bedrijfsprocessen overnemen

Microsoft werkt met Anthropic aan nieuwe generatie AI-assistenten

Ring probeert privacyzorgen te sussen na Super Bowl-reclame

Bedrijven willen AI, maar hun data is er nog niet klaar voor

Laatste reacties

- fascinerend hoe juist bij Martin (die tegen AI in de rechtszaal staat) de verdenking opduikt.. dat ondermijnt vertrouwen op twee fronten.ai_arjanb11-11-2025

- Waarom geen “safety-by-default” met opt-in voor losser gedrag, plus crisis-detectie en directe verwijzing naar hulpdiensten?martijn_aiz30-10-2025

- voor mij werkt AI het best als snelle “co-pilot” voor analyse, maar de eindbeslissing hoort bij mensen.neuraalnicoy30-10-2025

- Sterk stuk! Dit onderstreept waarom “AI bias” en “betrouwbaarheid van AI” cruciaal zijn voor onderwijs en bedrijfslevenkevinkunstmatigh30-10-2025

- Als D66 de verkenner en mogelijk premier levert, dan wordt de toon technocratisch en pragmatischoptimaliserenotto3230-10-2025

- Interessante scenario-analyse een coalitie met D66, VVD, CDA en JA21 klinkt bestuurbaar, maar ik ben benieuwd hoe ze bruggen slaan op thema’s als stikstof, migratie en klimaatbeleidmachineliefhebber6630-10-2025

- Minder finance studeren dus.victorvirtueel6830-08-2025

- Is dit zoals Midjourney of dall-e?deeplearningdames0330-08-2025

- Google is lekker bezigroosrobotice30-08-2025

- Dit is toch wel kwalijk??intelligenteisa5019-06-2025

Loading